Apache Hive: definición y aplicaciones

Aunque muchos expertos en software pronostican la desaparición del sistema de almacén de datos Apache Hive, hoy en día se sigue utilizando para la gestión de grandes cantidades de datos. Muchas de las funciones de Apache Hive también han resultado ser útiles en sistemas sucesores. Por lo tanto, merece la pena echar un vistazo más de cerca a Hive y a sus aplicaciones más importantes.

¿Qué es Apache Hive?

Apache Hive es una extensión escalable de la aplicación de servidor Apache y la arquitectura de almacenamiento Apache Hadoop. En las arquitecturas Hadoop, las tareas informáticas complejas se dividen en pequeños procesos y se distribuyen en paralelo en clusters de nodos informáticos utilizando clustering. Esto permite procesar grandes cantidades de datos incluso con arquitecturas estándar de servidores y ordenadores. Apache Hive sirve como sistema integrado de consulta y análisis de código abierto para tu data warehouse. Gracias a Hive, los datos pueden analizarse, consultarse y resumirse utilizando el lenguaje de bases de datos HiveQL, similar a SQL. Gracias a Hive, los datos de Hadoop también son accesibles a grupos más amplios de usuarios.

Con Hive, se utiliza una sintaxis similar a SQL:1999 para estructurar o integrar scripts en programas, aplicaciones y bases de datos. Antes de Hive, Hadoop requería conocimientos de programación Java y técnicas de programación para consultar datos. Gracias a Hive, las consultas pueden traducirse cómodamente al formato de sistema de la base de datos. Pueden ser, por ejemplo, tareas MapReduce. Con Hive, también es posible integrar otras aplicaciones basadas en SQL en el framework Hadoop. Debido al uso generalizado de SQL, Hive como extensión de Hadoop también facilita a los no expertos el trabajo con bases de datos y grandes conjuntos de datos.

¿Cómo funciona Hive?

Antes de que Apache Hive complementara el marco Hadoop, el ecosistema Hadoop seguía basándose en el framework MapReduce desarrollado por Google. En el caso de Hadoop 1, este aún se implementaba directamente en el framework como motor independiente para la administración, supervisión y control de recursos y procesos informáticos. Esto, a su vez, requería amplios conocimientos de Java para poder consultar con éxito los archivos de Hadoop.

Así, las principales funciones de Hadooop para el uso y gestión de big data residen en:

- resumen de datos

- consulta

- análisis

La funcionalidad de Hive se basa en un principio sencillo: con una interfaz similar a SQL, las consultas y análisis de archivos Hadoop pueden traducirse cómodamente en tareas MapReduce, Spark o Tez a través de HiveQL. Para ello, Hive organiza los datos del framework Hadoop en un formato de tabla compatible con HDFS. HDFS son las siglas de Hadoop Distributed File System. La recuperación selectiva de los datos se realiza entonces a través de clusters y nodos específicos del sistema Hadoop. Los filtros, agregaciones y uniones también están disponibles como funciones estándar.

Hive se basa en el principio Schema on Read

A diferencia de las bases de datos relacionales, que funcionan según el principio SoW (Schema on Write), Hive se basa en el principio SoR (Schema on Read). Esto significa que los datos en el framework Hadoop se almacenan inicialmente sin cambios y no en un esquema predefinido. Solo durante una consulta Hive se adaptan los datos a un esquema según sea necesario. La ventaja radica sobre todo en el cloud computing en una mayor escalabilidad, más flexibilidad y tiempos de carga más rápidos de las bases de datos distribuidas en clusters.

Cómo trabajar con datos en Hive

Para consultar y analizar datos con Hive, se utilizan tablas Apache Hive según un esquema de acceso de lectura. Con Hive, los datos se organizan y clasifican en estas tablas en unidades detalladas más pequeñas o en grandes unidades globales. Las tablas Hive se dividen en los llamados “buckets”, es decir, bloques de datos. Para acceder a los datos, se utiliza el lenguaje de base de datos HiveQL, que es similar a SQL. Entre otras cosas, las tablas Hive se pueden sobrescribir y anexar, así como serializar en bases de datos. Además, cada tabla Hive tiene su propio directorio HDFS.

Mantén tu base de datos bajo control con un alojamiento web Linux de IONOS. Ofrece un rendimiento escalable, SSL, protección DDoS y servidores alemanes seguros.

Las funciones más importantes de Hive

Las funciones básicas de Hive incluyen la consulta y el análisis de grandes conjuntos de datos almacenados como archivos Hadoop en un framework Hadoop. Una segunda tarea importante de Hive es la traducción de consultas en HiveQL a tareas MapReduce, Sparks y Tez.

Otras características destacables de Hive son:

- almacenamiento de metadatos en sistemas de gestión de bases de datos relacionales

- uso de datos comprimidos en sistemas Hadoop

- UDF (User Defined Functions) para la manipulación de datos personalizados y la minería de datos

- compatibilidad con tipos de almacenamiento como RCFile, Text o HBase

- uso de MapReduce y compatibilidad con ETL

¿Qué es HiveQL?

En relación con Hive, se suele hacer mención a su similitud a SQL. El lenguaje HiveQL de la base de datos Hive se basa en SQL, pero no se corresponde al cien por cien con estándares como SQL-92. Por tanto, HiveQL también puede entenderse en cierto modo como una especie de dialecto SQL o MySQL. A pesar de todas las similitudes, ambos lenguajes difieren en aspectos esenciales. Por ejemplo, HiveQL no admite muchas funciones SQL para transacciones o subconsultas, y a su vez proporciona una mejor escalabilidad y rendimiento en el framework Hadoop con sus propias extensiones como Multitable Inserts. El compilador Apache Hive traduce las consultas HiveQL a MapReduce, Tez y Spark.

Utiliza servidores dedicados con potentes procesadores Intel o AMD y ahorra en tu propia infraestructura con un servidor administrado de IONOS.

Seguridad de los datos y Apache Hive

Al integrar Apache Hive en sistemas Hadoop, también te beneficias del servicio de autenticación Kerberos. Esto permite una autenticación y verificación mutua fiable entre el servidor y los usuarios. Dado que HDFS también establece permisos para los nuevos archivos Hive, la autorización de usuarios y grupos dependerá de ti. Otro aspecto importante de la seguridad: Hive proporciona una eficaz recuperación ante desastres de cargas de trabajo críticas.

¿Qué ventajas ofrece Apache Hive?

Hive ofrece numerosas funciones útiles, especialmente para trabajar con grandes cantidades de datos en la computación en nube o en el caso de Big Data as a Service, tales como:

- consultas ad hoc

- análisis de datos

- creación de tablas y particiones

- compatibilidad con enlaces lógicos, relacionales y aritméticos

- seguimiento y revisión de transacciones

- informes al final del día

- carga de resultados de consultas en directorios HDFS

- transferencia de datos de tablas a directorios locales

Así, entre las principales ventajas figuran:

- permite obtener información cualitativa de grandes cantidades de datos, por ejemplo para data mining y machine learning

- optimiza la escalabilidad, la rentabilidad y la extensibilidad de los grandes frameworks Hadoop

- segmenta grupos de usuarios mediante análisis de clics

- no requiere un conocimiento profundo de los procedimientos de programación Java gracias a HiveQL

- ventajas competitivas gracias a una capacidad de respuesta y un rendimiento más rápidos y escalables

- permite almacenar hasta cientos de petabytes de datos y realizar hasta 100 000 consultas de datos por hora, incluso en una infraestructura de gama alta

- mejor aprovechamiento de los recursos gracias a la capacidad de virtualización y, por tanto, tiempos de computación y carga más rápidos en función de las cargas de trabajo

- seguridad de datos buena y tolerante a fallos gracias a mejores opciones de recuperación ante desastres y al servicio de autenticación Kerberos

- acelera la inserción de datos al eliminar la necesidad de adaptar los datos a los formatos internos de la base de datos (Hive lee y analiza los datos incluso sin un cambio de formato manual)

- funciona según el principio del código abierto

¿Qué desventajas tiene Apache Hive?

Entre las desventajas de Apache Hive destaca principalmente el hecho de que ya existen muchos sistemas sucesores que ofrecen prestaciones similares y mejores. Los expertos consideran que la relevancia de Hive en la administración y el uso de bases de datos es cada vez menor.

Otras desventajas de Hive son:

- no tiene acceso en tiempo real a los datos

- edición y actualización complejas de conjuntos de datos mediante el framework Hadoop con MapReduce

- alta latencia y, por tanto, más lento que los sistemas de la competencia según los estándares actuales

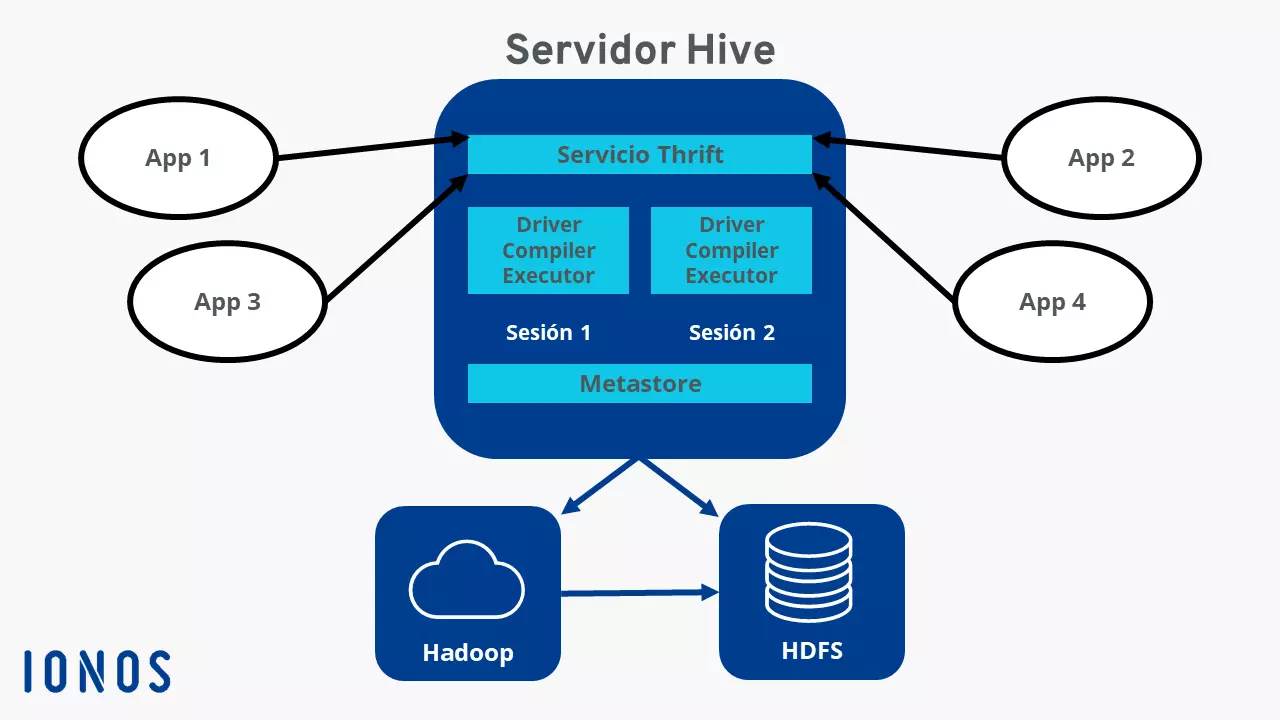

Un vistazo a la arquitectura de Hive

Los componentes más importantes de la arquitectura Hive incluyen:

- Metastore: la ubicación central de almacenamiento de Hive donde, como formato RDBMS, residen todos los datos e información como definiciones de tablas, ubicación de esquemas y directorios y metadatos de particiones

- Driver: recibe comandos HiveQL y los procesa utilizando los componentes Compiler (recopila información), Optimizer (determina el mejor método de ejecución) y Executor (implementa la tarea)

- Línea de comandos + Interfaz de usuario: interfaz para usuarios externos

- Thrift server: permite a los clientes externos comunicarse con Hive y permite a los protocolos JDBC y ODBC interactuar y comunicarse a través de la red

¿Cómo se creó Apache?

Apache Hive se diseñó para facilitar el trabajo con conjuntos de datos de petabytes a usuarios sin conocimientos de SQL profundos. El desarrollo se remonta a los fundadores Joydeep Sen Sharma y Ashish Thusoo, que desarrollaron Hive durante su etapa en Facebook en 2007 para el framework Hadoop de Facebook, uno de los mayores del mundo con varios cientos de petabytes. En 2008, Facebook cedió el proyecto Hive a la comunidad de código abierto. La versión 1.0 se publicó en febrero de 2015.