¿Qué es el referral spam y cómo enfrentarse a él?

El flujo de datos en una web, lo que se conoce como tráfico entrante, es uno de los indicadores de éxito más importantes. Métricas como los hits (peticiones al servidor), las visitas y las impresiones de página ayudan a los administradores de estas páginas a medir la circulación de los usuarios y a evaluar el rendimiento de sus proyectos analizando los archivos de registro o logfiles y utilizando soluciones de software online como Google Analytics o Piwik. Si en estos exámenes aparecen irregularidades, es posible que tengan que ver con el referral spam o spam de referencias. Sigue leyendo si quieres saber cómo descubrir estos ataques de spam y evitar las estadísticas falsas a largo plazo.

Referrer spam: conoce al tráfico “fantasma”

El spam de referencias es una forma de spam en buscadores en la que los hackers intentan manipular los archivos de registro y las estadísticas de ciertas páginas web con el objetivo de generar un tráfico falso para simular flujos de visitas o estimular visitas a su propia página web. Ambos patrones se apoyan para ello en unos programas denominados bots, abreviatura de robots, que en su gran mayoría funcionan de forma autónoma.

¿Qué son los spambots?

Los bots son programas informáticos que ejecutan tareas repetitivas automáticamente y constituye un componente fundamental del Internet que conocemos hoy en día. De hecho, buscadores como Google o Bing utilizan este tipo de programas, es decir, web crawlers (rastreadores web) o robots de búsqueda (search bots) para explorar la red e indexar las páginas más relevantes. Pero los hackers también los utilizan para automatizar sus incursiones, si bien en este caso su uso no se supedita a los intereses del usuario, como sí sucede en el de las “arañas” de los buscadores, sino a alguno de estos objetivos:

- Generar clics automáticos en anuncios (Click Fraud)

- Recolectar un gran número de direcciones de correo electrónico.

- Crear cuentas de usuario generadas automáticamente

- Distribuir publicidad en comentarios generados de forma automática

- Difundir software dañino

El spam de referencias también suele apoyarse en programas automatizados, que se dividen en dos grandes categorías:

- Programas que simulan visitas: los spambots de este tipo imitan a los navegadores más habituales como Chrome, Firefox o Safari y envían numerosas peticiones HTTP a determinados servidores web. Estos programas funcionan de forma semejante a los bots de los operadores de los buscadores (Google), que a veces se camuflan como navegadores web (Firefox) para comprobar cómo se lee una página con un explorador u otro. Dado que en este tipo de spam estos programas simulan la visita de un usuario humano a una web, este tipo de ataque recibe el nombre de crawling spam y como sus efectos se manifiestan también en el archivo de registro del servidor, suele también denominarse logfile spam

- Programas que falsifican datos de tráfico: los spambots de esta clase copian los datos de tráfico de otras páginas web y los guardan en el servidor de herramientas de análisis web sin ser vistos. Un ataque de este tipo permite manipular estadísticas web sin siquiera entrar en contacto con la página afectada, porque no aparece en el archivo de registro del servidor, sino solamente en los informes del software de análisis manipulado. En este caso se habla de ghost spam.

A continuación explicamos ambos tipos de ataque de spam y cómo defenderse de ellos.

Crawler spam

La mayoría de servidores web suele llevar un archivo de registro central, el access log, en el cual se protocolizan todas las peticiones en secuencia cronológica con su sello de hora y fecha. El siguiente ejemplo muestra una entrada en el registro de accesos de un servidor Apache en Combined Log Format:

127.0.0.1 - frank [10/Oct/2000:13:55:36 -0700] "GET /apache_pb.gif HTTP/1.0" 200 2326 "www.example.com/start.html" "Mozilla/4.08 [en] (Win98; I ;Nav)

Esta entrada contiene la siguiente información:

| Información | Ejemplo | |

|---|---|---|

| Dirección IP del host solicitante | 127.0.0.1 | |

| Nombre de usuario desde una autenticación HTTP | frank | |

| Cronosellador | [10/Oct/2000:13:55:36 -0700] | |

| Petición HTTP | GET /apache_pb.gif HTTP/1.0 | |

| Código de estado HTTP | 200 | |

| Tamaño del archivo | 2326 | |

| Referer [sic] | http://www.example.com/start.html | |

| Agente de usuario (navegador) | Mozilla/4.08 [en] (Win98; I ;Nav) |

Los spammers aprovechan el protocolo automático mediante logfile para infiltrar su propio URL en el protocolo de servidor de determinadas páginas web mediante el envío masivo de peticiones HTTP. Aquí es primordial el campo “Referer” de la petición, que contiene el URL de la página web que refiere (fuente del enlace).

Debido a un error ortográfico en la especificación de HTTP se ha establecido “Referer” como la denominación de este campo en el encabezado HTTP. En otros estándares se utiliza la forma correcta con doble r.

Si un usuario pincha en un hiperenlace, este le lleva a la página web enlazada desde la página web actual. En el campo “Referer” se registra entonces el URL de la página web en la que se encuentra el enlace porque es esta la que “refiere” a otra página. Si analiza el archivo de registro, este campo permite al administrador de la página enlazada saber qué páginas enlazan a su proyecto e identificar fuentes de tráfico en potencia. En el pasado fue habitual, especialmente en la escena de los bloggers, publicar los referentes incluidos en el archivo de registro en un widget de forma que podía mostrarse públicamente el origen del flujo de visitas. En esta lista de referentes se incluía un enlace a la fuente de tráfico, procedimiento que los spammers aprovecharon para manipular los archivos de registro de todo tipo de blogs y webs con el fin de posicionar a sus propios proyectos de la forma más ventajosa en estas listas públicas de enlaces y generar, así, más enlaces y visitas. En la actualidad aún se utilizan spambots especiales que envían peticiones masivas a páginas web y entregan a los servidores el URL de la página web cuya visibilidad se debe reforzar como referente. Con todo, este tipo de amenazas ha disminuido enormemente en parte porque hoy apenas se encuentran ya listas de referentes generadas automáticamente en las páginas web, lo que guarda relación, entre otras cosas, con los cambios substanciales en el algoritmo de ranking de Google. Al menos desde la actualización Penguin, introducida en abril de 2012, Google ha focalizado su atención en el spam web en el contexto de los backlinks, hasta el punto de que se penalizan los proyectos con una optimización del perfil de enlaces especialmente llamativa. Este sería el caso, por ejemplo, de páginas que incluyen un gran número de enlaces entrantes de entornos irrelevantes, de listas y redes de enlaces, de directorios de artículos o de comentarios en blogs. Hoy los análisis de los archivos de registro rara vez se realizan manualmente, sino con herramientas como Webalizer, AWStats o Piwik. Otras herramientas de analítica web como Google Analytics ofrecen la posibilidad de analizar los datos de tráfico sin tener que acceder a los archivos de registro del servidor, aunque esto no les hace menos vulnerables al crawler o al ghost spam.

Identificar el crawler spam

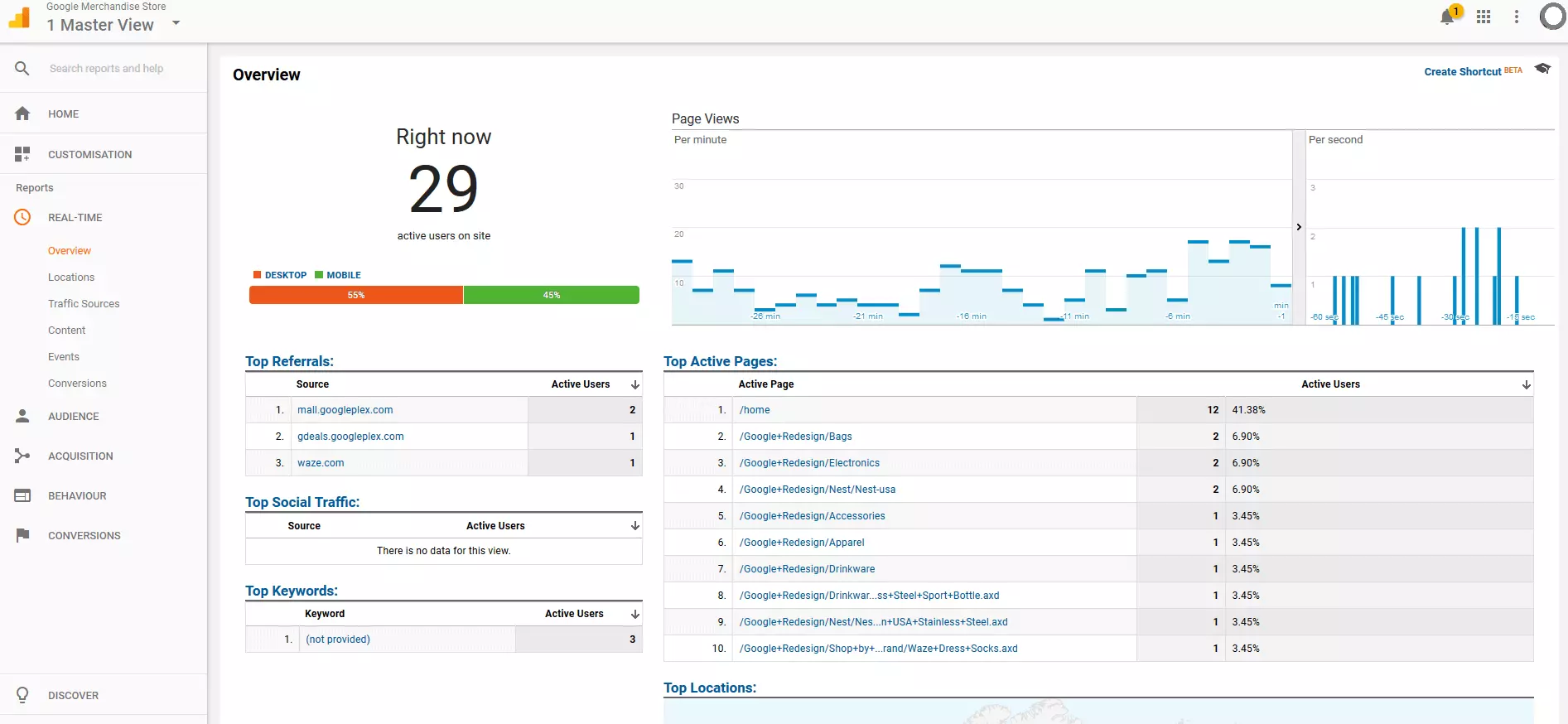

A continuación te mostramos cómo detectar el spam de “arañas” en la estadística de tu proyecto y filtrar referrer llamativos con Google Analytics.

- Abre la cuenta de tu proyecto en Google Analytics.

Todas las capturas de pantalla de la vista web de Google Analytics proceden de la versión en inglés de la cuenta de demostración facilitada por Google. El enlace a la cuenta está disponible en las páginas de ayuda de Google Analytics. Para acceder a ella se debe tener una cuenta de Google

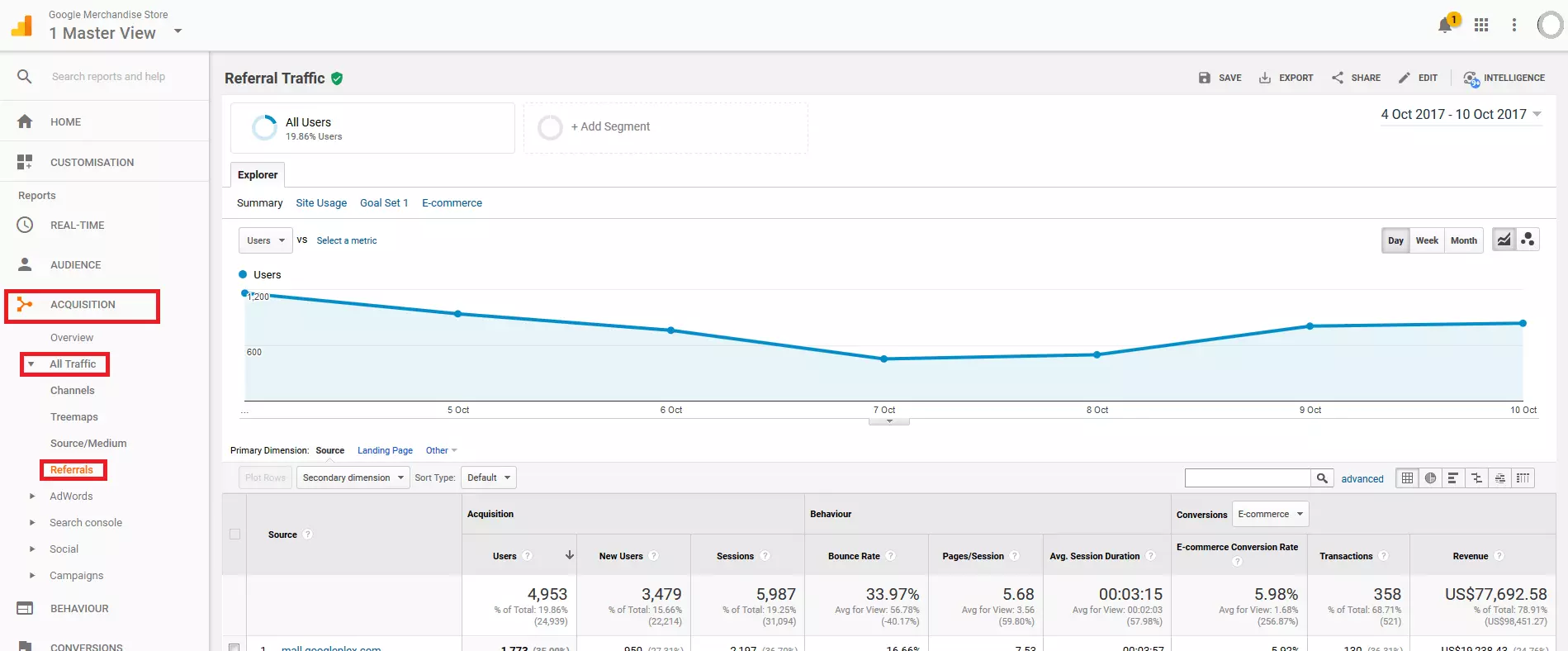

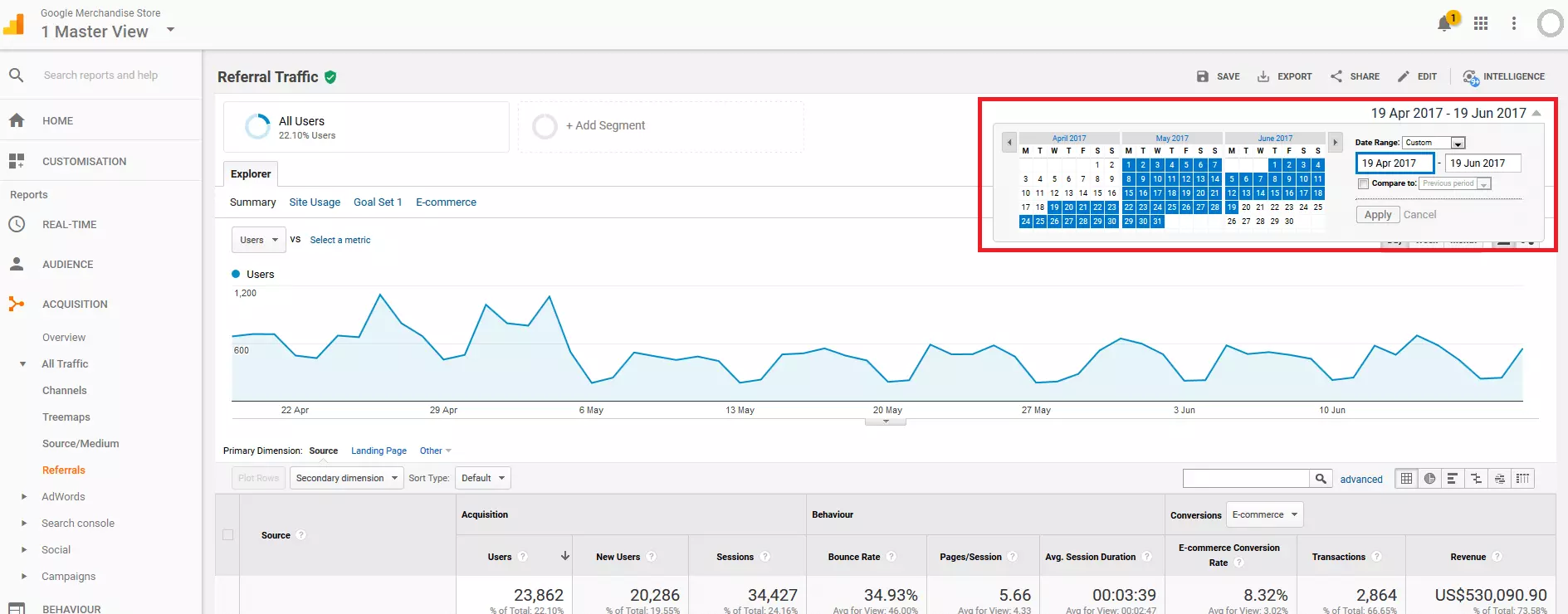

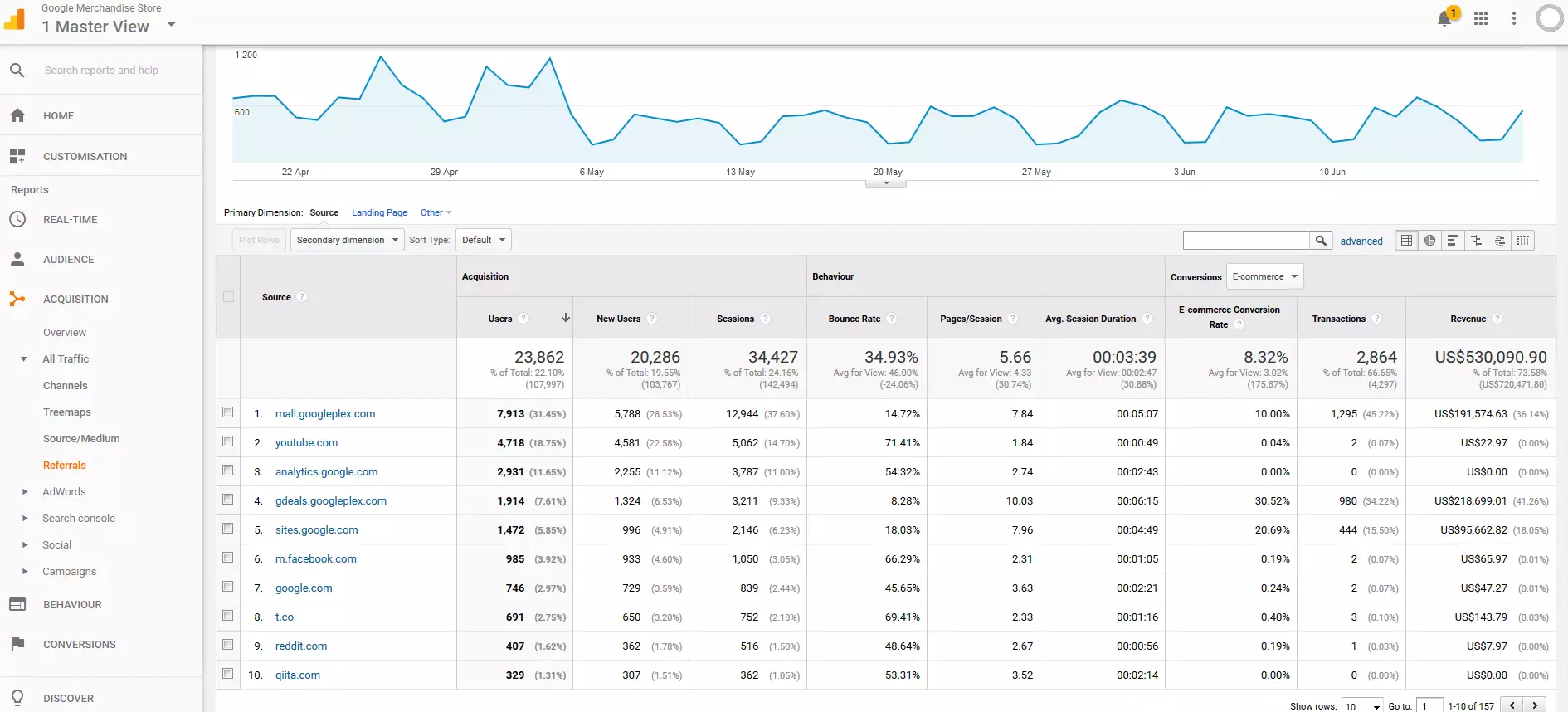

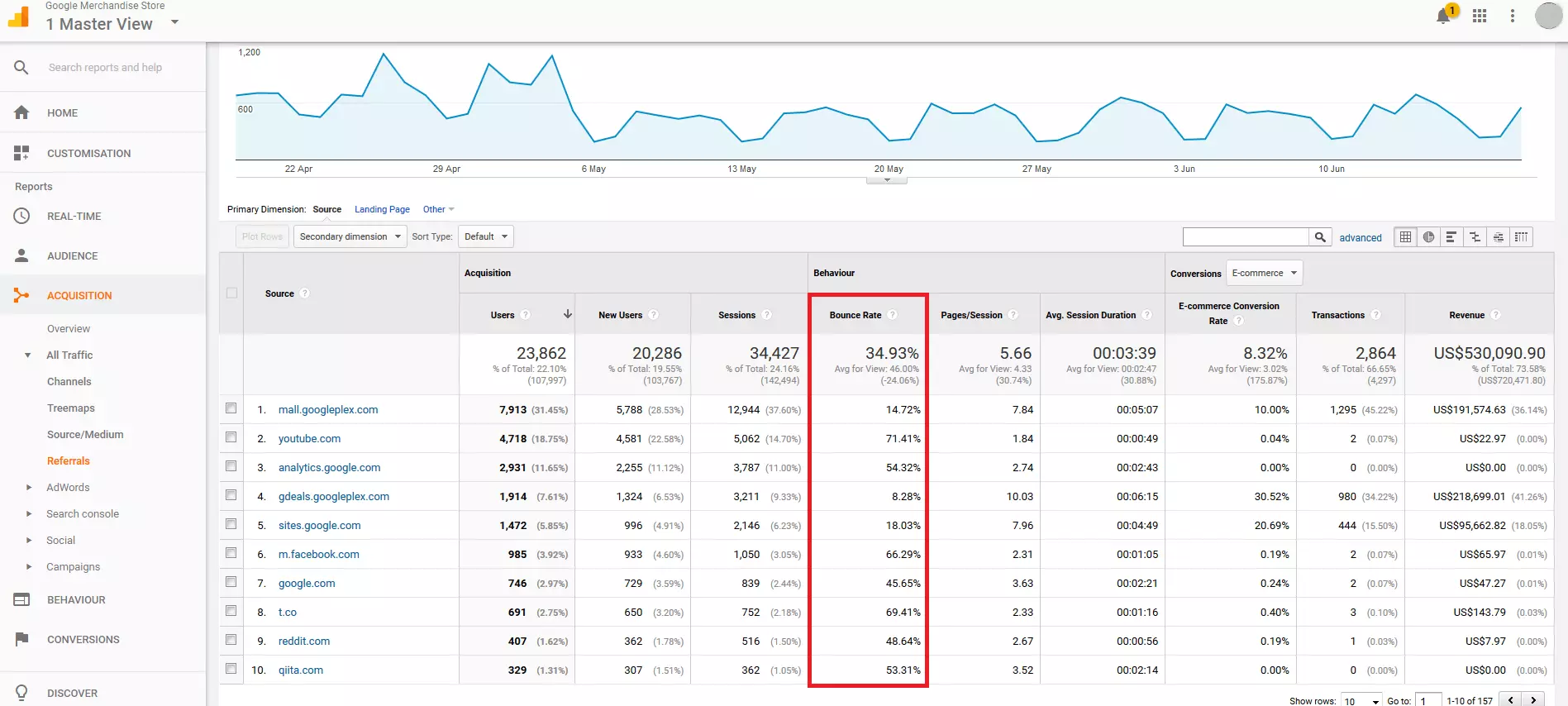

- Clasifica y filtra la estadística: en “Adquisición” > “Todo el tráfico” > “Referencias” Google Analytics sintetiza como dimensión primaria en un informe todas las fuentes de los hiperenlaces entrantes. Es así como se obtiene una lista de todos los URL referentes registrados por Google Analytics en el periodo seleccionado así como los valores métricos de cada uno de ellos.

Para cada enlace referente la herramienta proporciona el número de usuarios y sesiones que ha generado, así como también permite extraer datos como la tasa media de rebote, la cantidad de páginas visionadas por sesión, la duración media de cada sesión, las tasas de conversión, las transacciones y la facturación generada. Relevantes para la prevención de spam son sobre todo el número de sesiones por cada enlace así como la tasa media de rebote. Si pinchas en la columna “Porcentaje de rebote” en “Comportamiento” los valores de esta columna se estructuran en orden descendiente, de forma que resulta más sencillo detectar valores inusuales.

El porcentaje indicado como tasa de rebote muestra las sesiones procedentes de una misma fuente en las cuales no ha habido ningún tipo de interacción con tu página, es decir, la han visitado y la han abandonado poco después. Una tasa de rebote de un 100 o un 0 por ciento en más de 10 sesiones desde la misma fuente es un indicio claro de peticiones automatizadas.

También es posible filtrar la vista con una expresión regular (RegEx) que incluya los enlaces más conocidos de spam. Entre estos se incluyen las siguientes páginas:

- semalt.com

- darodar.com

- hulfingtonpost.com

- buttons-for-website.com

- best-seo-solution.com

- free-share-buttons.com

La agencia digital holandesa Stijlbreuk facilita en referrerspamblocker.com una extensa referrer spam blacklist o lista negra de spam de referencia

El patrón de filtrado con una expresión regular podría resultar así:

semalt|darodar|hulfingtonpost|buttons-for-website|best-seo-solution

La barra vertical (|) equivale al conector “o”. Los caracteres meta, como el punto, se deben enmascarar con una barra inversa (\) o backslash.

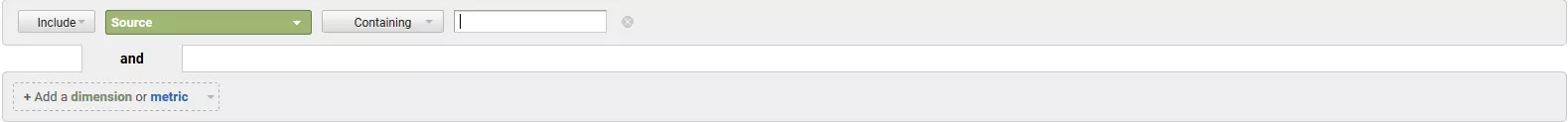

Para aplicar el filtro, pincha en “Avanzado” en la barra de menú superior:

Crea aquí un filtro para la dimensión “Fuente” y selecciona como opción de filtro “Contiene”, donde incluyes una expresión regular como patrón. Guarda los cambios y confirma.

- Anota los referral llamativos: crea tu lista negra de referentes spam con todos los URL sospechosos que actúan de fuente del enlace. Esta lista se utiliza más tarde como base para configurar un filtro de exclusión.

Bloquear el crawler spam con .htaccess

El crawler spam presupone una visita a la página. Por ello, las medidas preventivas más fiables se aplican en el lado del servidor. Para mostrar cuál es el procedimiento a seguir nos basamos en el archivo de configuración .htaccess del servidor web más utilizado a nivel global, Apache. Si has dado con URL sospechosos en tu estadística, puedes impedir que los spambots inicien sesión en tu página de tres formas diferentes:

- Bloquear los referrers

- Bloquear las direcciones IP

- Bloquear los agentes de usuario

Bloquear los referral con .htaccess

Abre el fichero .htaccess de tu servidor web y añade un fragmento de código como en el ejemplo:

RewriteEngine on

RewriteCond %{HTTP_REFERER} ^https?://([^.]+\.)*semalt\.com\ [NC,OR]

RewriteCond %{HTTP_REFERER} ^https?://([^.]+\.)*darodar\.com\ [NC,OR]

RewriteCond %{HTTP_REFERER} ^https?://([^.]+\.)*hulfingtonpost\.com\ [NC,OR]

RewriteCond %{HTTP_REFERER} ^https?://([^.]+\.)*buttons\-for\-website\.com\ [NC,OR]

RewriteCond %{HTTP_REFERER} ^https?://([^.]+\.)*best\-seo\-solution\.com\ [NC,OR]

RewriteCond %{HTTP_REFERER} ^https?://([^.]+\.)*free\-share\-buttons\.com\ [NC]

RewriteRule .* - [F]La defensa contra el spam en el lado servidor se basa (última línea) en la RewriteRule: .* - [F]

Esta regla de reescritura indica al servidor web que debe responder a todas las peticiones HTTP con el código de estado 403 Forbidden (“prohibido”) siempre que cumplan con una o varias de las condiciones (RewriteCond) citadas anteriormente. Esto impide el acceso de los robots de spam.

En nuestro ejemplo cada referente que debe bloquearse se ha definido en una RewriteCond separada como expresión regular, como se ve en el ejemplo:

RewriteCond %{HTTP_REFERER} ^https?://([^.]+\.)*semalt\.com\ [NC,OR]La condición se cumple cuando la variable de servidor %{HTTP_REFERER} se corresponde con la expresión regular definida en la RewriteCond, por ejemplo:

^https?://([^.]+\.)*semalt\.com\Las condiciones están unidas con la bandera [OR] que equivale al conector lógico “o”: basta con que se cumpla solo una RewriteCond para que se aplique la RewriteRule. [NC] define la secuencia como not case-sensitive, es decir, que no diferencia entre mayúsculas o minúsculas.

Con las RewriteCond también pueden definirse ciertas palabras clave que pueden llevar a exclusión si aparecen en el referrer de una petición HTTP. En el ejemplo que sigue se bloquean todas las peticiones HTTP cuyos referentes incluyen alguna de las palabras clave porn, pill o póker. Las palabras clave se delimitan por medio de una RegEx. Puedes usar el carácter meta \b:

RewriteEngine on

RewriteCond %{HTTP_REFERER} \bporn\b [NC,OR]

RewriteCond %{HTTP_REFERER} \bpill\b [NC,OR]

RewriteCond %{HTTP_REFERER} \bpoker\b [NC]

RewriteRule .* - [F]Si no se delimitaran podría ocurrir que también se bloquearan peticiones HTTP que incluyeran las mismas combinaciones de letras pero en otro contexto, como sería el caso de estos ejemplos:

manu.sporny.org/

www.rittersporn-zuchter.de/

www.fersensporn-online.de/

Bloquear direcciones IP con .htaccess

Si te has dado cuenta de que todos los ataques de spam proceden siempre de las mismas direcciones, puedes optar por bloquear sus correspondientes IP o regiones completas de direcciones. En el caso de bloquear una única dirección IP del lado del servidor copia en el fichero un bloque de código según este ejemplo:

RewriteEngine On

Order Deny,Allow

Deny from 203.0.113.100

Allow from allAquí, todas las peticiones HTTP que proceden de la dirección IP 203.0.113.100 serán rechazadas en el futuro de forma automática. En este bloque de código se pueden incluir tantas direcciones IP como sea necesario (una debajo de la otra):

RewriteEngine On

Order Deny,Allow

Deny from 203.0.113.100

Deny from 192.168.0.23

Allow from allSi, en cambio, es a un área de direcciones al completo al que se ha de impedir el acceso a tu web, utiliza el siguiente esquema en formato CIDA (Classless Inter-Domain Routing):

RewriteEngine On

Order Deny,Allow

Deny from 198.51.100.0/24

Allow from allCon estas líneas de código se bloquean todas las peticiones del área IP comprendida entre 198.51.100.0 y 198.51.100.255.

Es preciso tener en cuenta que los hackers suelen recurrir a las llamadas redes de bots (botnets) para enviar el mayor número posible de peticiones desde direcciones IP diferentes a la mayor brevedad posible. Esto hace que sea prácticamente imposible evitar ataques de spam por este método a largo plazo.

Una botnet o red de bots consiste en una red de ordenadores o equipos «zombi» infectados que se utilizan para lanzar ataques de spam o para distribuir software malicioso. Para crearla, los hackers (botmasters) introducen sus programas dañinos a través de Internet en ordenadores protegidos de forma insuficiente y utilizan sus recursos de red para infectar a otros participantes. Las redes de bots suelen obedecer a un control central y son el punto de partida de virulentas olas de infecciones y de ataques DDOS a gran escala.

Bloquear user agents con .htaccess

Otra alternativa que permite impedir ataques de spam consiste en bloquear determinados agentes de usuario cuya identificación utilizan los spam bots para hacerse pasar por visitantes legítimos.

Crea un código como en este ejemplo:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} Baiduspider [NC]

RewriteRule .* – [F,L]Hace algunos años los administradores web registraban constantemente ataques de spambots que simulaban ser robots de búsqueda del buscador chino Baidu (Baiduspider). Si no esperas obtener un tráfico orgánico significativo desde China puedes bloquear a este rastreador sin problemas para evitar así ataques de spam.

Filtros de referrer spam en Google Analytics

Las medidas de prevención en el lado del servidor vía .htaccess constituyen la forma más sostenible de impedir el crawler spam, si bien la configuración del archivo es compleja y vulnerable a errores. Esto hace que no todos los webmasters se atrevan a formular sus propias reglas Rewrite y por un buen motivo, pues cualquier error podría tener consecuencias decisivas en la disponibilidad de la página web. Pero los programas de análisis también permiten filtrar peticiones automáticas de spambots para evitar informes falsificados. Seguidamente mostramos el procedimiento a seguir con Google Analytics.

La herramienta ofrece dos opciones con las que filtrar el referral spam de la estadística:

- Las referrer spam blacklists de Google

- Filtros personalizados

El siguiente vídeo forma parte del “Digital Analytics Fundamentals Course” de la Analytics Academy y ofrece una introducción a los filtros de la herramienta de Google:

Para mostrar este video, se requieren cookies de terceros. Puede acceder y cambiar sus ajustes de cookies aquí.

Para mostrar este video, se requieren cookies de terceros. Puede acceder y cambiar sus ajustes de cookies aquí. Referrer spam blacklist de Google

Google ya ha reconocido el problema del referral spam en la evaluación de las estadísticas de usuario. Es por esto que la herramienta permite filtrar todos los bots y todas las arañas conocidas automáticamente. Procede de la siguiente manera para ello:

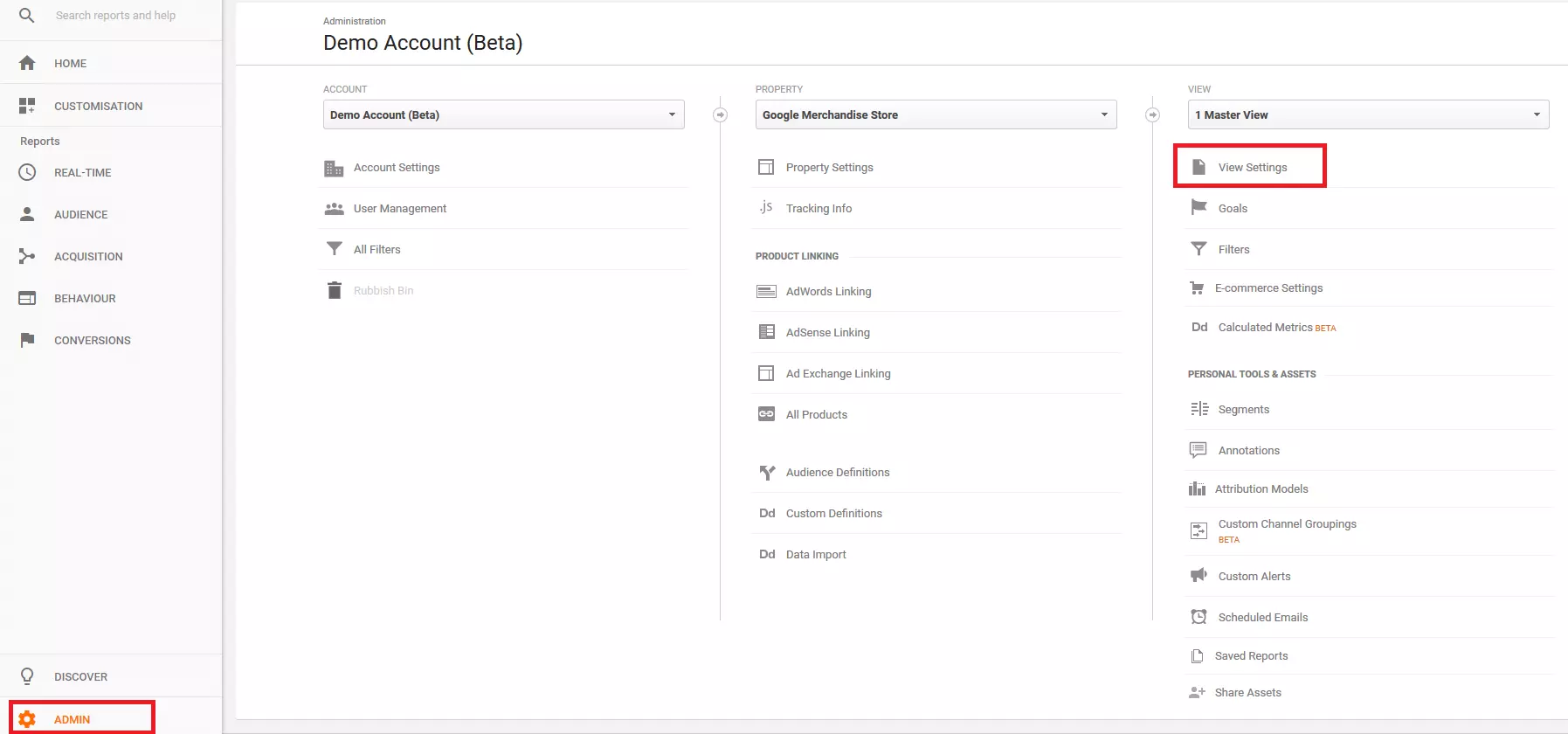

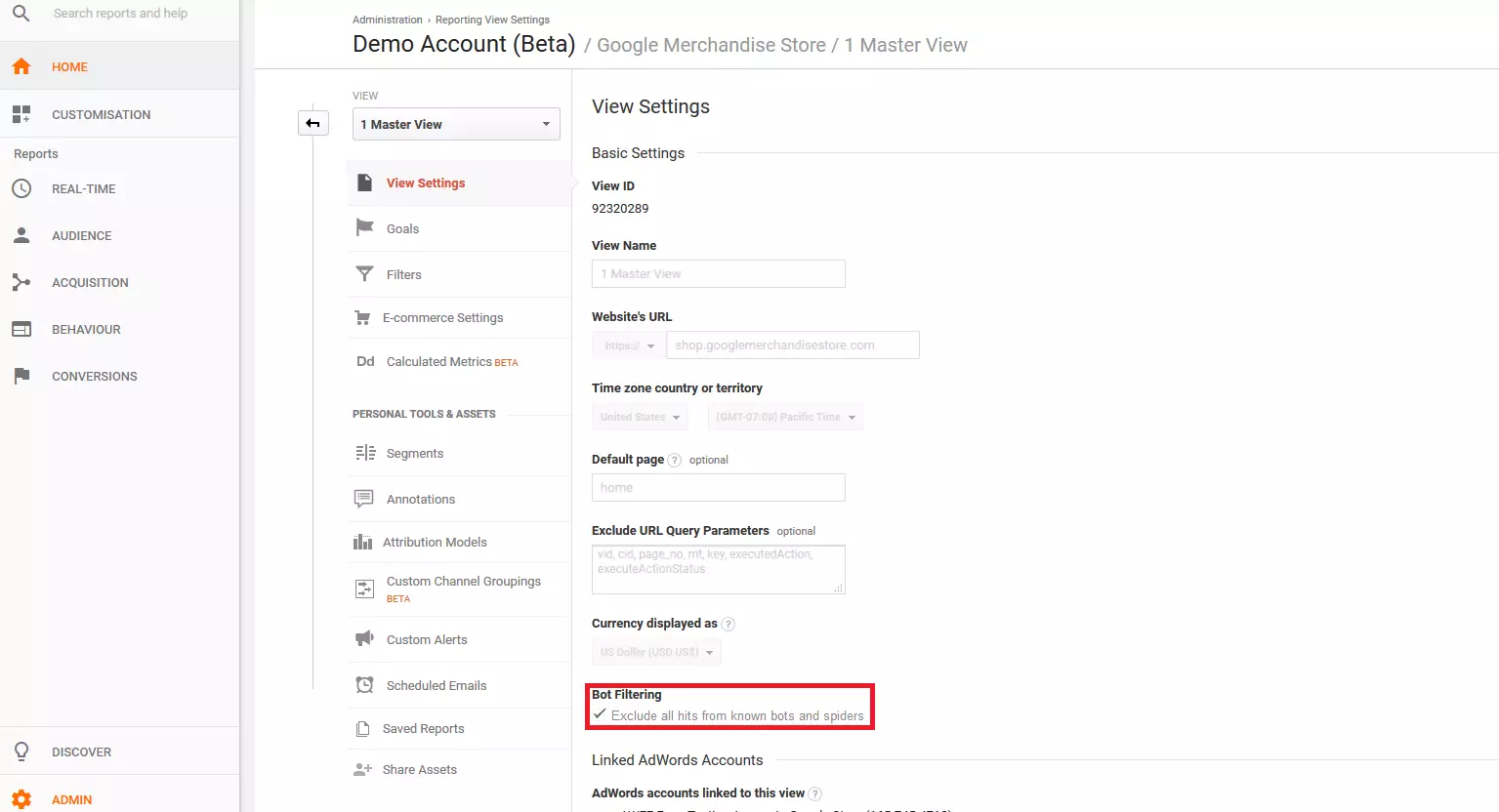

- Abre los ajustes de la vista maestra: cuando abras tu cuenta ve a la sección de administración, selecciona la vista y a continuación pincha en “Ver configuración”.

- Activa la lista negra de referentes de Google: desliza el ratón hasta la opción “Filtrado de bots” y marca la casilla para excluir las peticiones al servidor de bots y arañas conocidos. Google muestra entonces una versión depurada de la estadística de tu web.

Recuerda que solo se filtrarán los datos de usuario que la herramienta pueda asignar a spambots conocidos. Esto quiere decir que el filtro solo puede actuar contra robots y arañas incluidos en la lista negra de Google.

Filtros personalizados por el usuario

La herramienta de Google también permite definir filtros para la cuenta o para la vista de datos. Los primeros pueden aplicarse a otras vistas si es necesario, mientras que los segundos solo son válidos para la vista para la que se crearon.

Prueba los filtros recién creados en una copia de la vista seleccionada de esta forma:

- Crea una copia de la vista: entra en el menú “Ver configuración” y haz clic en la opción para copiar la vista. Nombra y guarda la copia y confirma el proceso.

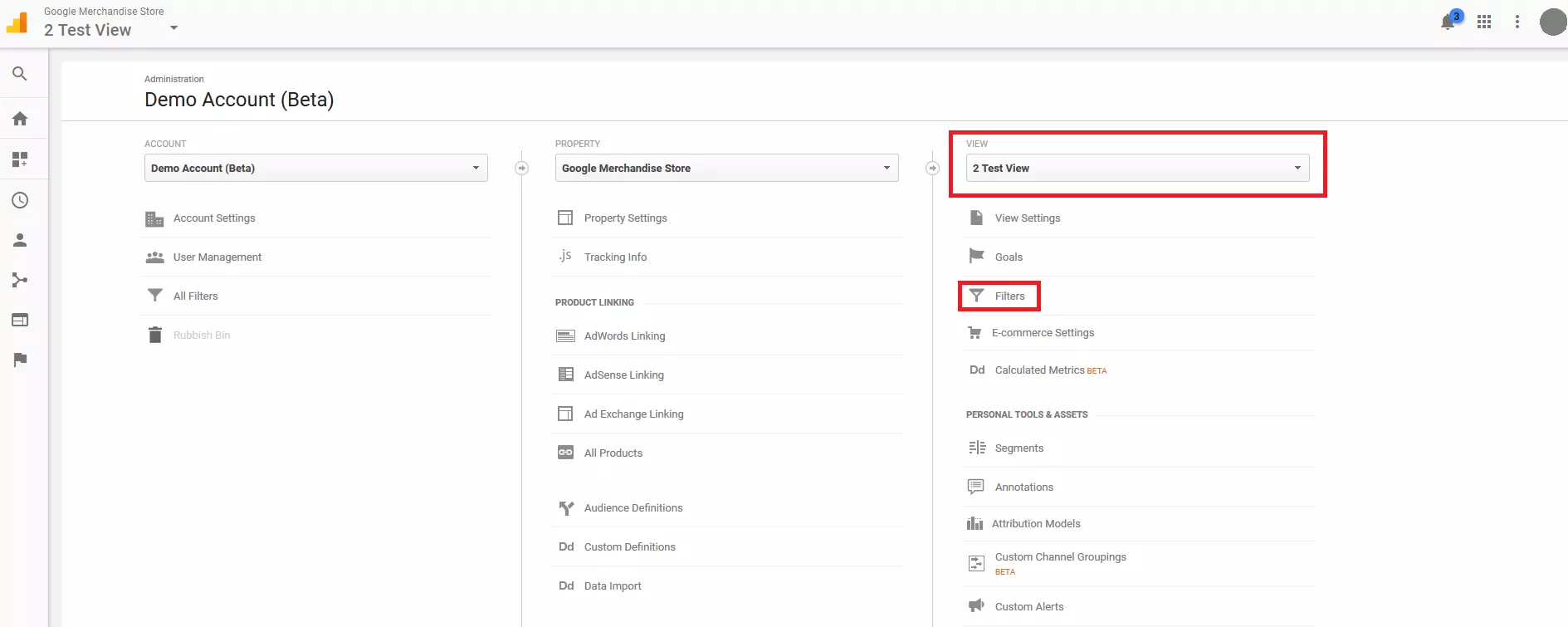

- Define filtros personalizados: selecciona la copia que has creado en “Ver” y pincha en “Filtros”

Si con anterioridad hubieras creado otros filtros, la herramienta los mostraría en este panel.

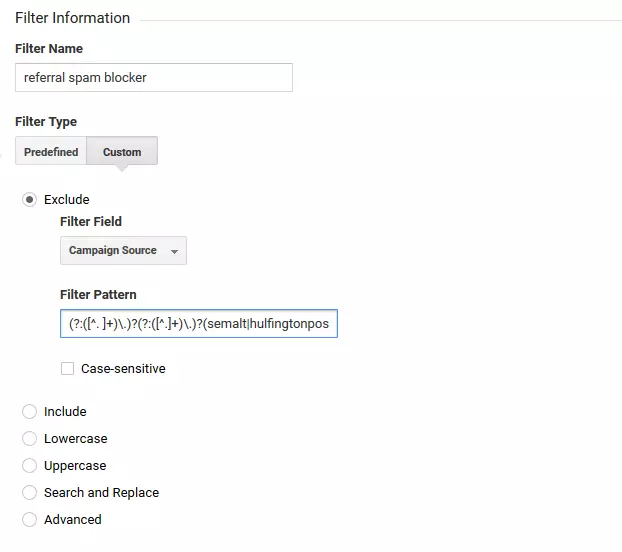

Ahora puedes crear un filtro nuevo pinchando en el botón correspondiente (“+ Agregar filtro”). Nombra a este nuevo filtro (referrer spam blocker) y escoge estas opciones:

- “Tipo de filtro”: “Personalizado”

- “Excluir”

- “Campo de filtro”: “Fuente de campaña”

El campo “Fuente de campaña” define a la dimensión “Fuente” en los informes de Google Analytics.

Ahora puedes crear el “Patrón para el filtro” en la forma de expresión regular. Para ello utiliza la lista negra que has creado anteriormente. Este patrón podría resultar algo así:

(?:([^. ]+)\.)?(?:([^.]+)\.)?(semalt|hulfingtonpost|buttons-for-website|best-seo-solution)\.(com|de|net|org|ru)- Verifica los filtros: a continuación comprueba el funcionamiento del filtro para ver cómo repercute en la vista actual.

Solo es posible verificar el filtro cuando la vista contiene datos suficientes.

Guarda los cambios y cierra la configuración. El nuevo filtro se muestra en la vista maestra.

- Aplica el filtro sobre la vista maestra: si el filtro que has definido funciona como es debido, utilízalo en la vista maestra de tu cuenta.

Los filtros representan una buena oportunidad para depurar los informes de referral spam, pero debes recordar que lo único que hace esta función es dejar de mostrar el tráfico ocasionado por los bots. El problema real, la carga del servidor por los ataques de spam, no queda resuelto. La prevención sostenible contra el spam solo es efectiva si se toman medidas en el lado servidor que impidan el acceso automático de los spambots.

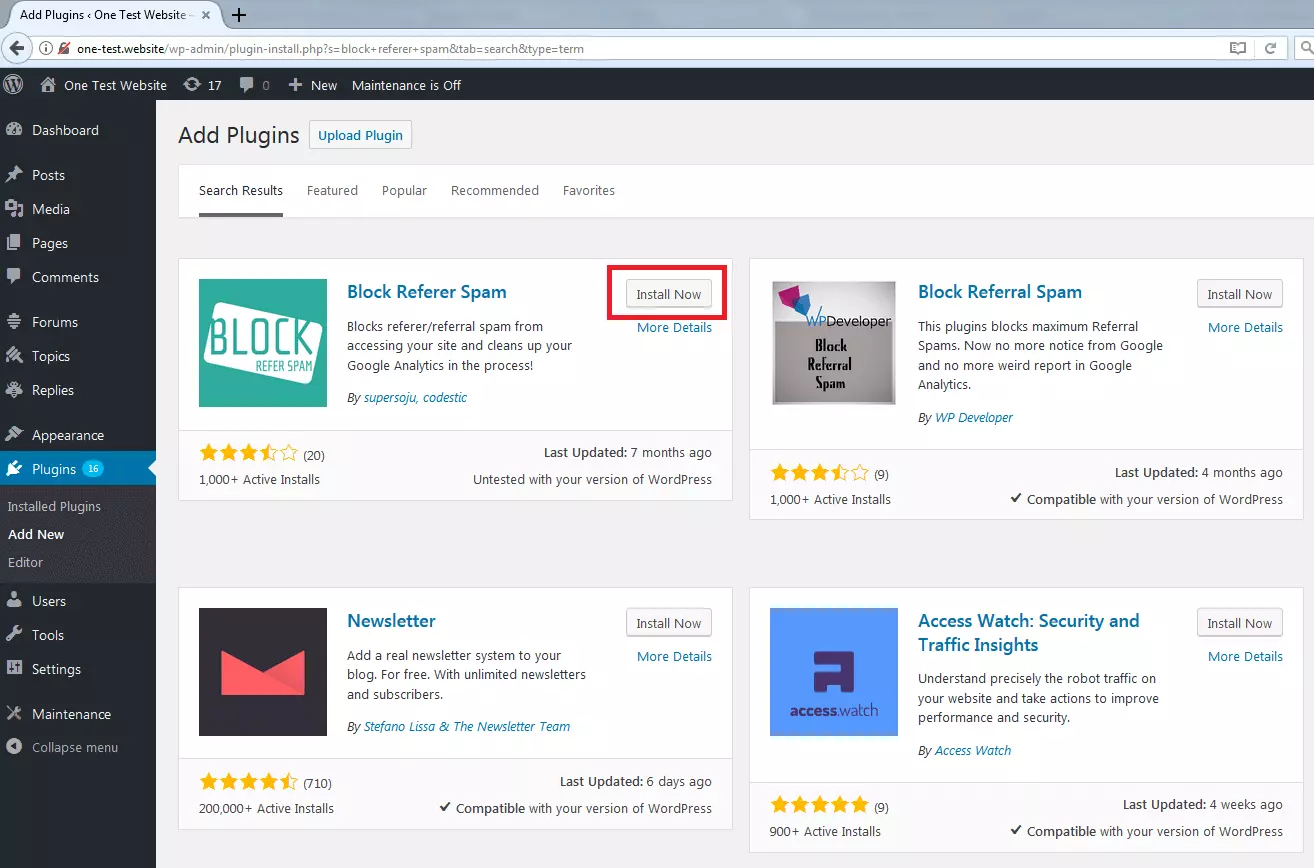

Bloquear el crawler spam en WordPress

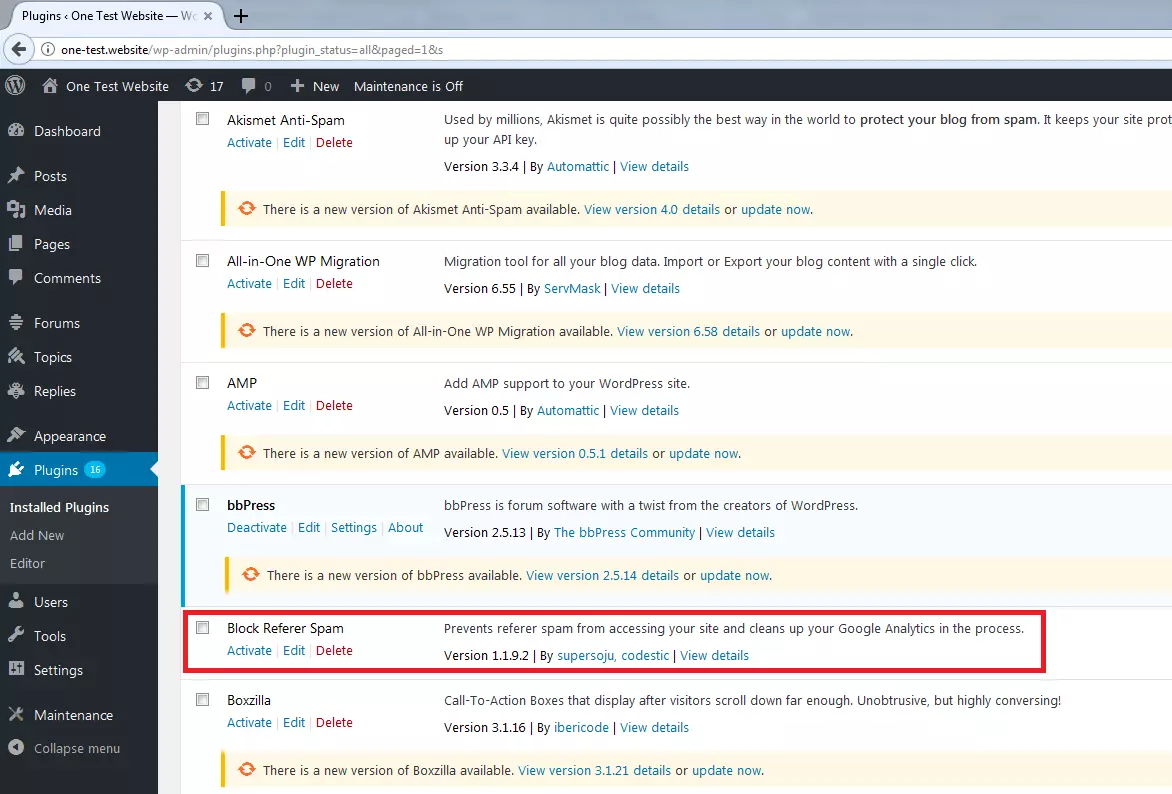

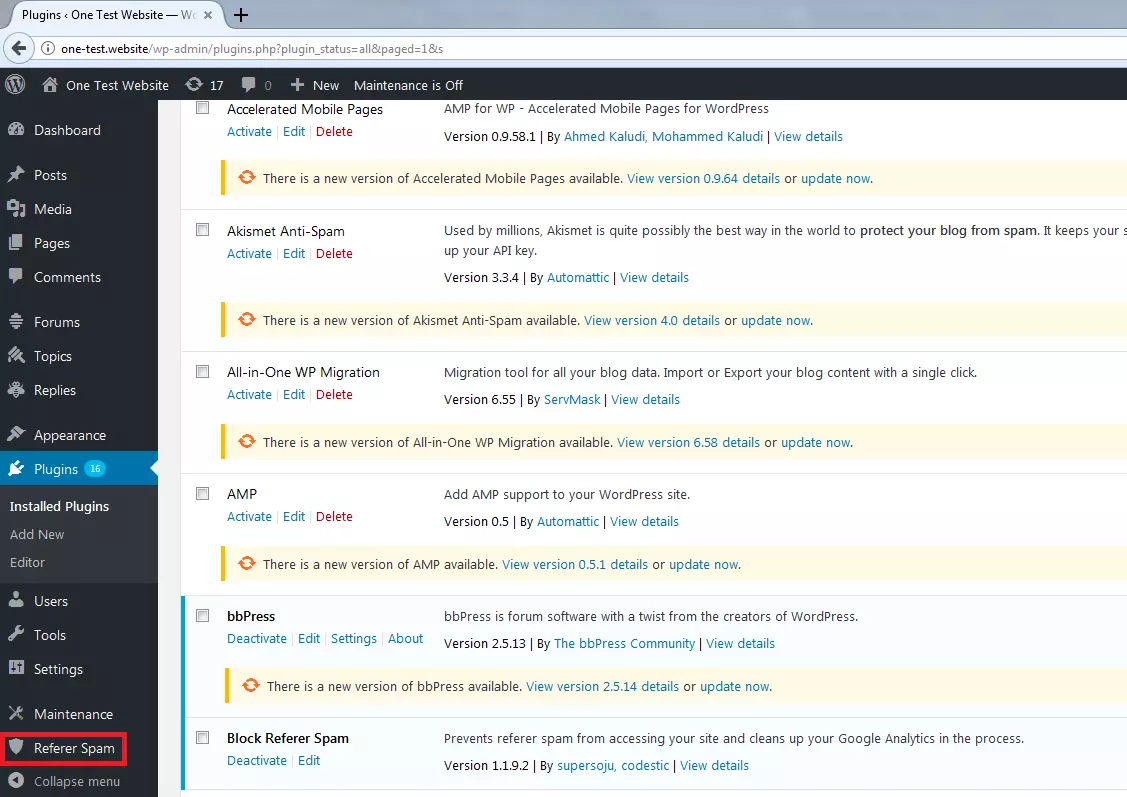

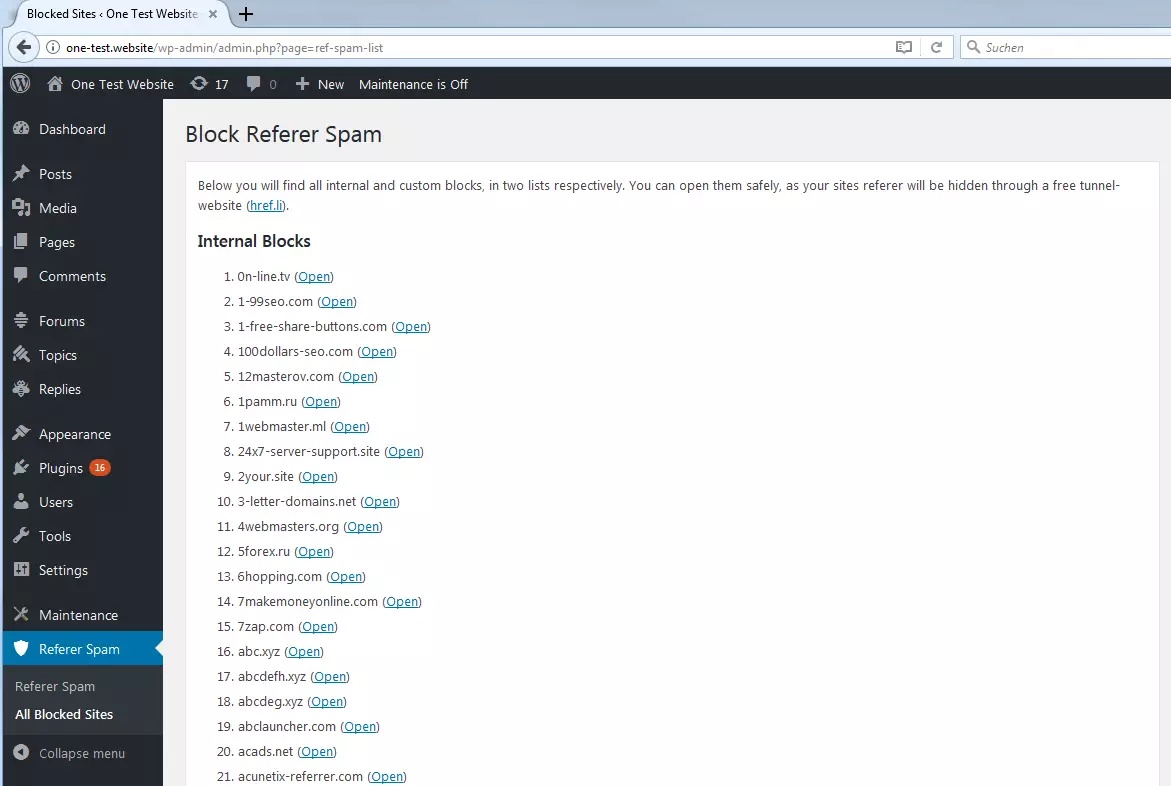

Los administradores de páginas WordPress pueden proteger su proyecto del spam de “arañas” mediante plugins disponibles de forma gratuita en la página de WordPress. Entre los más populares y actualizados regularmente se encuentran:

Instalar el plugin contra el referral spam

En el gestor de contenidos WordPress los plugins se gestionan desde el panel de administración. Procede de la siguiente manera:

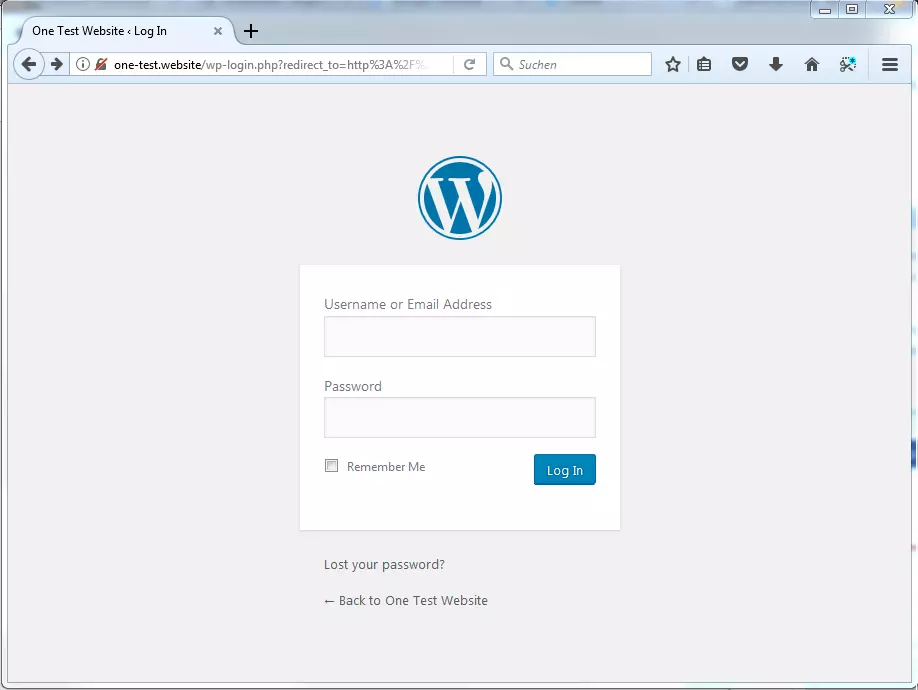

- 1Abre el panel de administración de WordPress: antes de activar el plugin contra el referral spam entra en tu cuenta y ve a la sección de administrador.

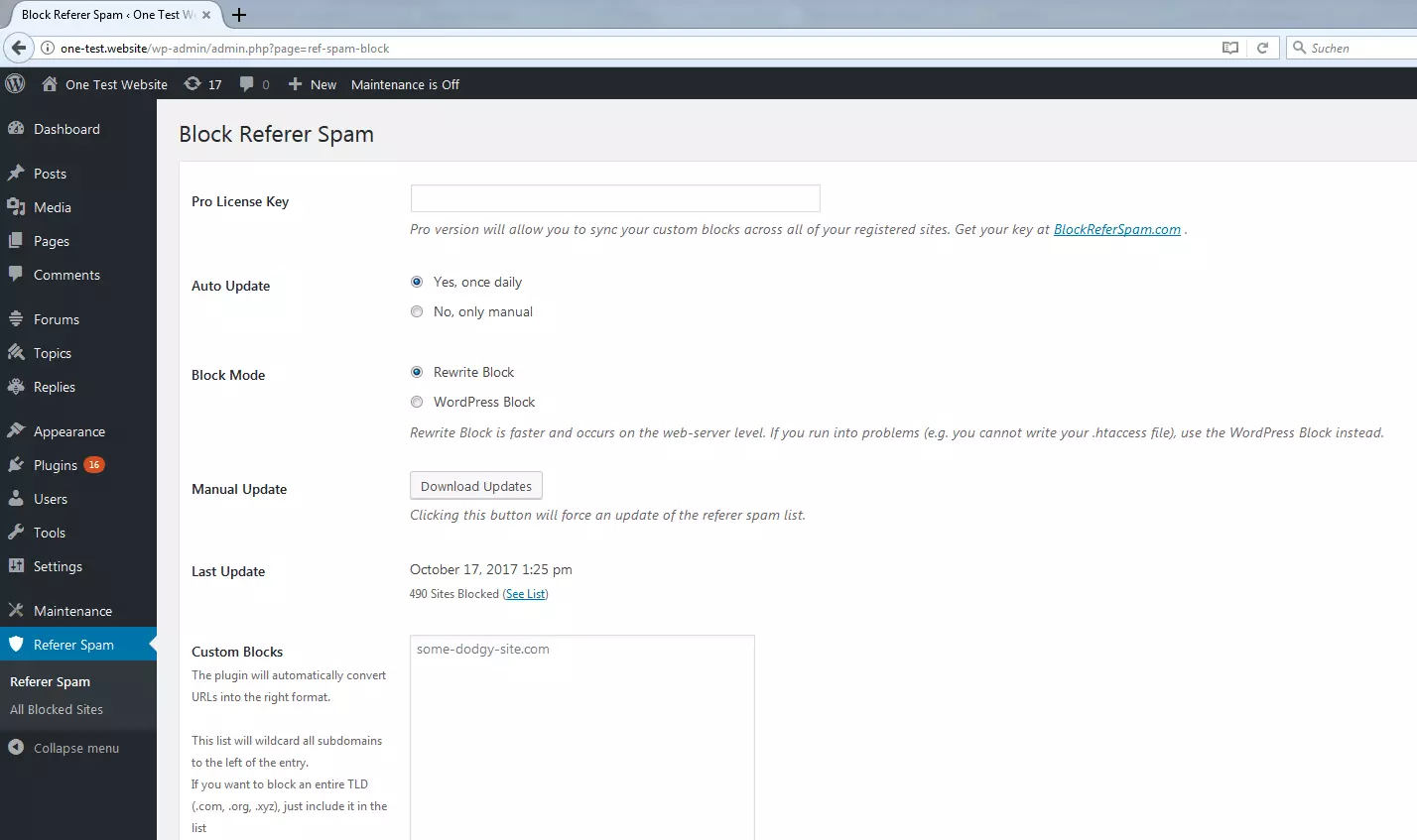

Configura el plugin de bloqueo de spam de referencias

Selecciona la actualización automática para tener la seguridad de que la lista negra del plugin se amplía con direcciones spam a medida que se van conociendo.

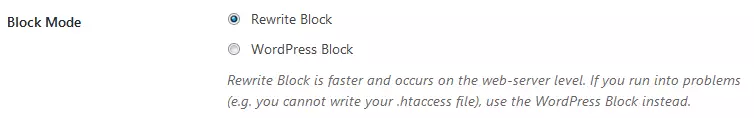

La opción más recomendable en este caso es el bloqueo Rewrite, mucho más efectivo y rápido, ya que impide el acceso de spam ya en el servidor.

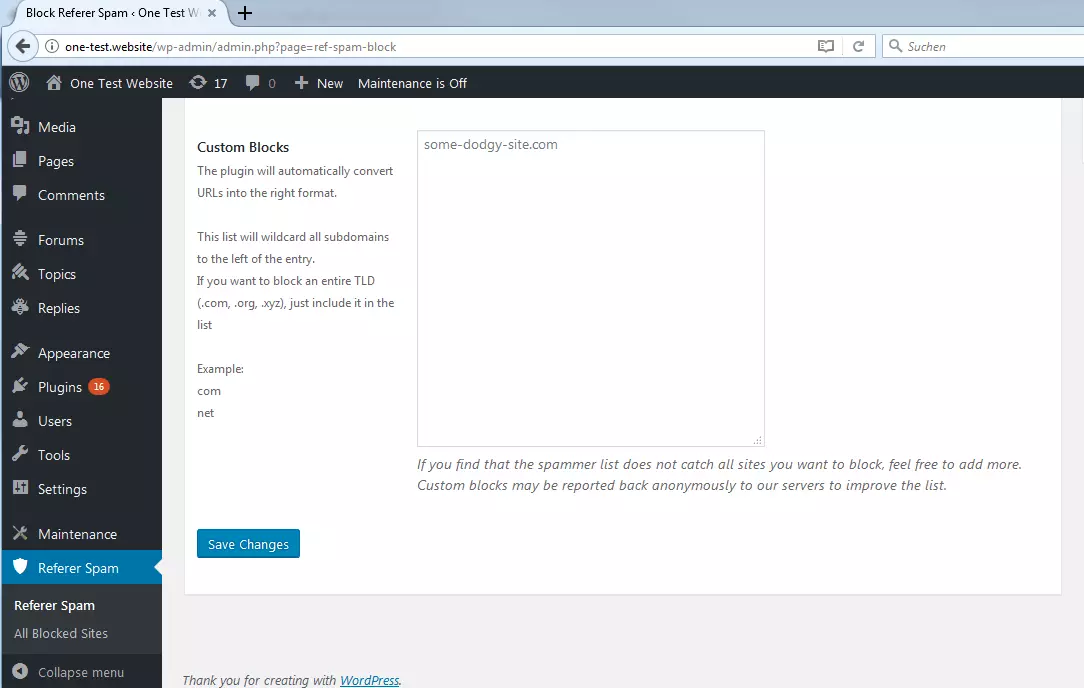

- Crea una blacklist de referrer spam personalizada: una forma aún más efectiva de bloquear el spam es ampliar la lista negra manualmente escribiendo en el campo “Custom Blocks” todas aquellas páginas web que llamen tu atención.

Ghost spam

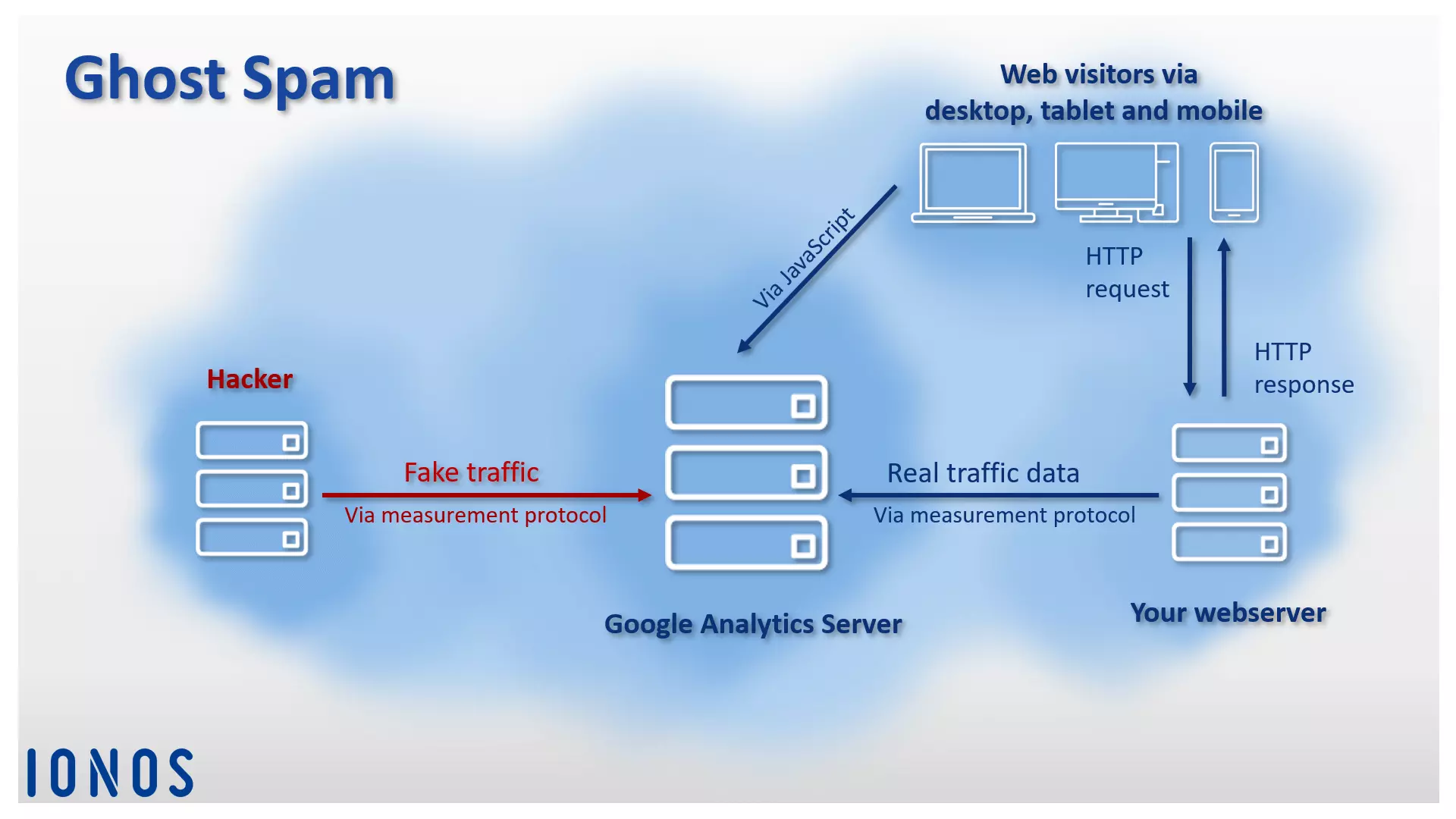

A diferencia del crawler spam, el spam “fantasma” no necesita interactuar con la página web a la que se dirige porque los bots envían los datos de tráfico falsificados directamente al servidor de las herramientas de análisis, las cuales procesan estos datos sin distinguirlos de los datos de usuario legítimos y los envían como informes a los administradores web. El no tener contacto en ningún momento con la página web es lo que ha dado el nombre de tráfico fantasma, spam fantasma o ghost spam a este tipo de ataque. Ahora bien ¿cuál es la intención de los spammers al llevarlo a cabo?

El objetivo de un ataque de ghost spam no es otro que el de despertar la curiosidad de los webmasters, pues suponen que cuanto más a menudo aparezca su URL en los informes de otras páginas, más elevada es la probabilidad de que sus gestores quieran conocer de dónde procede tanto tráfico. Pero lo que estos dominios suelen ocultar son páginas web con anuncios de display que obtienen financiación con las visitas. En los peores casos, los administradores de estos dominios pueden incluso utilizar el spam de referencias para contagiar los equipos de los usuarios más inocentes con programas dañinos.

Recurrimos de nuevo a Google Analytics para mostrar cuál es el mecanismo interno del spam fantasma y qué medidas de defensa pueden adoptarse.

¿Cómo funciona el ghost spam?

En este tipo de ataque los ciberdelincuentes explotan las posibilidades del measurement protocol (protocolo de medición) de Google Analytics, que es precisamente el que hace posible el envío de los datos de tráfico entre tu página web y el servidor web de la herramienta.

Todo lo que necesitan los hackers para infiltrar datos en Google Analytics es disponer de los identificadores de seguimiento válidos, a los cuales pueden llegar de dos formas:

- Utilizando spambots que rastreen el código HTML de las webs y copien los identificadores.

- Con un generador que cree ID de seguimiento al azar.

Numerosos webmasters incluyen este código de seguimiento en la misma hoja de HTML de su página. Esto se hace con el siguiente código:

<!-- Google Analytics -->

<script>

window.ga=window.ga||function(){(ga.q=ga.q||[]).push(arguments)};ga.l=+new Date;

ga('create', 'UA-XXXXX-Y', 'auto');

ga('send', 'pageview');

</script>

<script async src='https://www.google-analytics.com/analytics.js'></script>

<!-- End Google Analytics -->Para que el script pueda enviar los datos a Google Analytics se debe escribir el identificador de seguimiento individual de cada usuario en el lugar de UA-XXXXX-Y. A este identificador puede acceder cualquier programa que pueda leer el código HTML de una página web.

Esta vulnerabilidad puede cubrirse con ayuda del Administrador de etiquetas de Google, herramienta que facilita a los administradores web una interfaz de usuario para gestionar de forma centralizada los fragmentos de código de Google, denominados tags (etiquetas) por el proveedor. En lugar de utilizar varias etiquetas para cada uno de los servicios de Google se integra un solo snippet de código para el Google Tag Manager en el código HTML. De esta forma se protege al código de seguimiento de Google Analytics junto al ID individual del posible acceso de terceros.

El tráfico fantasma puede afectar, en principio, a cualquier tipo de informe realizado con la herramienta de análisis: además de los datos sobre los referentes, los spammers también utilizan los informes sobre eventos, palabras clave, páginas de destino o ajustes de idioma para introducir datos de tráfico manipulados.

La persona con más éxito en la escena del ghost spam es hasta ahora el hacker ruso Vitaly Popov, que desde 2014 no ha dejado de colar los URL de sus webs en cuentas de Google Analytics. A finales de 2016 consigue burlarse de la comunidad internauta con una supuesta página secreta de Google: junto a terminaciones habituales como de, de-de o en-us, miles de usuarios de Analytics a lo largo y ancho del globo encontraron el siguiente mensaje en los informes sobre los ajustes de idioma de sus visitas:

„Secret.ɢoogle.com You are invited! Enter only with this ticket URL. Copy it. Vote for Trump!“

Aquellos gestores más curiosos que siguieron la invitación no fueron a parar a Google, pues:

ɢoogle.com ≠ Google.com

En lugar de eso, el URL redirigía a la página web de Popov, cuya dirección contiene el texto casi completo de “Money”, una de las canciones más populares de Pink Floyd incluida en “The dark side of the moon” de 1973.

money.get.away.get.a.good.job.with.more.pay.and.you.are.okay.money.it.is.a.gas.grab.that.cash.with.both.hands.and.make.a.stash.new.car.caviar.four.star.daydream.think.i.ll.buy.me.a.football.team.money.get.back.i.am.alright.jack.ilovevitaly.com/#.keep.off.my.stack.money.it.is.a.hit.do.not.give.me.that.do.goody.good.bullshit.i.am.in.the.hi.fidelity.first.class.travelling.set.and.i.think.i.need.a.lear.jet.money.it.is.a.secret.%C9%A2oogle.com/#.share.it.fairly.but.dont.take.a.slice.of.my.pie.money.so.they.say.is.the.root.of.all.evil.today.but.if.you.ask.for.a.rise.it’s.no.surprise.that.they.are.giving.none.and.secret.%C9%A2oogle.com

Dicho URL conducía a una página web, hoy ya no disponible, al estilo de un catálogo web de principios de los años 2000 con enlaces a diversos buscadores y tiendas online. No está claro qué pretendía Popov con su ataque de spam, aunque puede suponerse que lo que le interesaba era comprobar el potencial del URL de typosquatting ɢoogle.com.

Puede afirmarse que si bien el tráfico fantasma es molesto, no representa un peligro para tu página web porque no implica un contacto real con ella, por lo que ni el servidor ni los archivos de registro se ven afectados por un gran número de peticiones automáticas. No obstante, sí puede llegar a ser problemático a la hora de analizar las estadísticas de referrer spam con Google Analytics.

Evita abrir referencias oscuras en el navegador web porque corres el riesgo de que la página a la que lleve el enlace infecte tu sistema con software dañino.

Identificar el spam fantasma

El ghost spam suele basarse en ID de seguimiento generados por azar. Por eso el spambot desconoce a qué página web afecta el ataque. Esto se hace patente por medio de incoherencias en los datos proporcionados por la herramienta de Google.

Cuando un usuario entra en una web a través de un enlace el encabezado de la petición, recibe en el campo “Host” el nombre de un equipo que se puede asociar a tu red. Los bots que envían tráfico falso, en cambio, no conocen este nombre de equipo de forma que en este campo introducen un número cualquiera o lo dejan vacío (Google Analytics registra a este host como “(not set)”, “sin definir”.

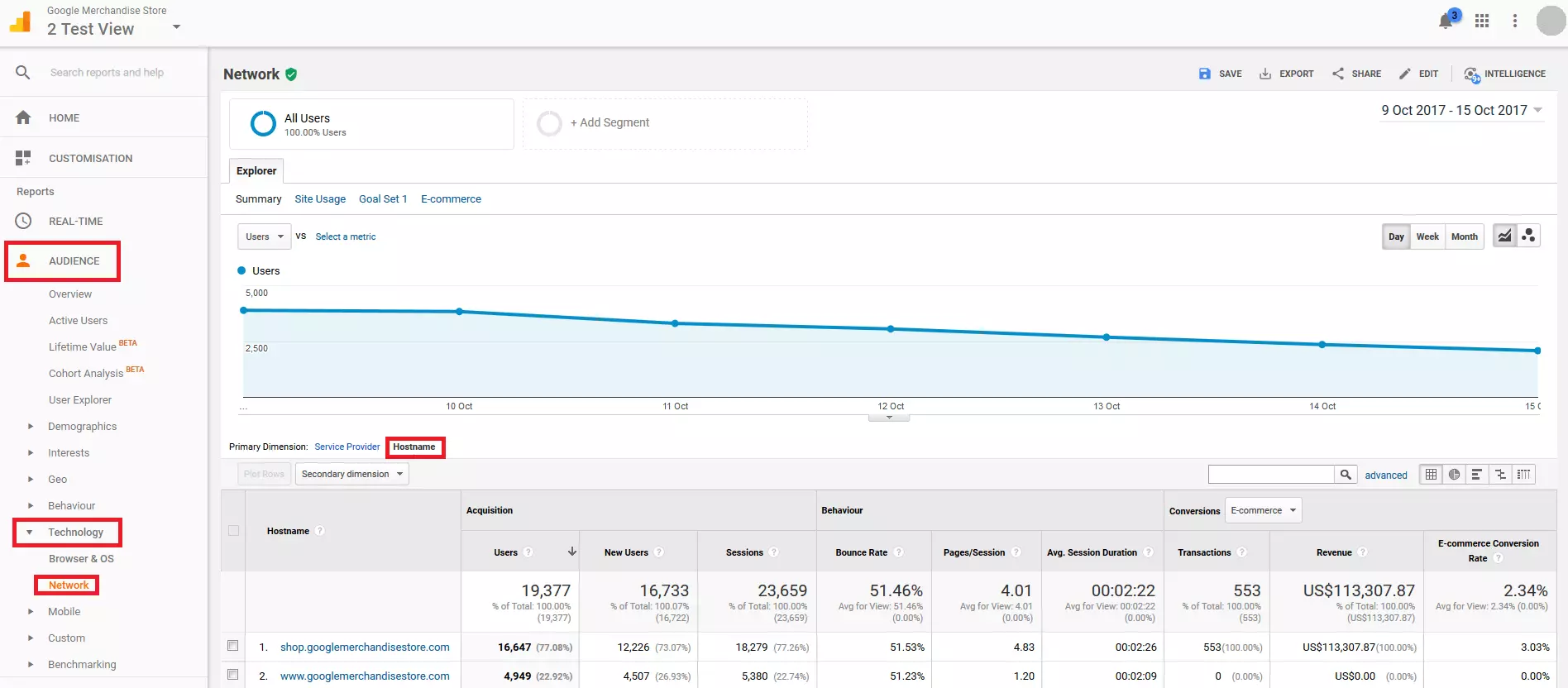

Utiliza este esquema para identificar el tráfico fantasma en tu cuenta de Google Analytics. Se recomienda seguir este procedimiento:

- Abre el informe de red: desde “Audiencia” y “Tecnología” selecciona el informe “Red” y cambia a “Nombres de host” como dimensión primaria.

- Ajusta el periodo de observación: define el periodo que será objeto del examen como el de los últimos tres meses.

- Identifica números de host legítimos: en la primera columna del informe la herramienta presenta todos los nombres de host desde los cuales se visitó la página. Aquí deberían aparecer sobre todo nombres que se pueden asociar a los dominios de tu página web. También se encuentran aquí dominios de Google responsables de traducciones y de las versiones de caché de la web.

translate.googleusercontent.com

webcache.googleusercontent.com

Si encuentras aquí nombres de equipo que no se corresponden ni con tus dominios ni con las páginas de Google, estás ante un caso de ghost spam.

- Define una expresión regular: anota todos los nombres de host de los que quieres estudiar los datos de tráfico como una expresión regular como en el ejemplo, que servirá como modelo para el filtro:

^(www\.)?(example|googleusercontent)\.com

La expresión regular ha de incluir todos los nombres de host cuyo tráfico vas a analizar con la herramienta.

El ghost spam se reconoce siempre que el host que consta en la petición HTTP no coincida con el host de tu red.

Filtrar el tráfico fantasma

Filtrando todos aquellos nombres de host que no pertenecen a tu red se eliminan del informe. Para ello se usa un filtro incluyente para la vista de datos.

- Selecciona la copia de la vista: en la sección de administración de tu cuenta copia la vista maestra o escoge una copia realizada con anterioridad.

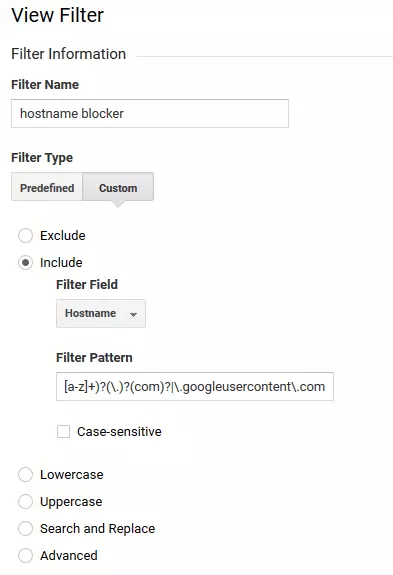

- Define el filtro: en el punto “Filtros” pincha en “Nuevo Filtro” y “Crear Nuevo Filtro”.

Introduce un nombre para el filtro (por ejemplo, hostname blocker).

En “Información del filtro” selecciona los ajustes:

- “Tipo de filtro”: “Personalizado”

- “Incluye”

- “Campo de filtro”: “Nombre de host”

En “Patrón de filtro” introduce la expresión regular que creaste anteriormente para incluir en la vista solamente los nombres de host de tu red.

- Verifica los filtros: pincha en “Verificar filtros” para probar su efecto en la vista seleccionada y guárdalo.

- Aplica el filtro en la vista maestra: si funciona sin problemas aplícalo a la vista principal de los datos.

Ahora ya no deberían verse los datos de usuario enviados como ghost spam y podrías evaluar el tráfico de tu página web estadísticamente con la seguridad de contar con información veraz y fiable.