Los data warehouses y la toma de decisiones en la empresa

Los sistemas de apoyo a la toma de decisiones tienen una larga tradición en el mundo de los negocios. Ya desde la década de 1960, las empresas utilizan todo tipo de métodos analíticos que permiten obtener datos útiles con el objetivo de respaldar a la dirección ejecutiva en la planificación estratégica de los procesos de negocio con informes, modelos y pronósticos basados en datos.

Estos sistemas de información analíticos con funcionalidades de evaluación pueden clasificarse como sistemas de información gerencial (Management Information Systems, MIS), sistemas de soporte a decisiones o DSS (Decision Support Systems) o sistemas de información ejecutiva (Executive Information Systems, EIS), los cuales apenas se diferencian entre sí y desde los 1990 se engloban bajo el denominador común de Business intelligence (BI) o inteligencia de negocios tanto en la práctica empresarial como en la comercialización de sus productos.

la Business Intelligence (BI) comprende el tratamiento y el análisis de datos en bruto por medios informáticos. La inteligencia de negocios tiene el fin de generar el conocimiento que ha de servir como fundamento de la planificación estratégica de la empresa.

En el contexto de la Business Intelligence, hoy la base de estos sistemas de información la proporciona generalmente un depósito central de datos que se conoce como Data Warehouse (DWH, en español almacén de datos). A continuación explicamos qué es un almacén de datos y cuál es su estructura y presentamos diferentes soluciones de software para instalar y gestionar un data warehouse tanto de proveedores comerciales como de código abierto.

¿Qué es un data warehouse?

Un almacén de datos es un sistema de base de datos separado de los sistemas operativos de procesamiento de datos (bases de datos transaccionales), en el cual se comprimen y guardan a largo plazo datos procedentes de fuentes diferentes y en ocasiones muy heterogéneas. Muchas empresas vuelcan periódicamente los datos históricos que guardan estas bases de datos transaccionales en un almacén de datos, donde los preparan y limpian para poder acceder a ellos más tarde y analizarlos estratégicamente en el marco de la inteligencia empresarial. En este trasvase los datos operativos (transaccionales) se convierten en datos preparados y útiles:

- Datos operativos: se trata de información transaccional que generan los sistemas de administración y cuentas en la práctica comercial cotidiana. Entre las fuentes típicas de datos transaccionales se cuentan sistemas de administración de datos como los programas de contabilidad, los sistemas de gestión de mercancías, los sistemas de planificación de recursos de empresa (ERP) o los sistemas de ayuda y pedido.

- Datos útiles: son los datos que resultan cuando los datos operativos de uso cotidiano se agrupan, guardan, depuran y preparan para el análisis en un lugar central separado.

Un DWH les ofrece a los analistas un amplio campo de visión sobre datos de origen muy heterogéneos y permite agregar indicadores operativos en el contexto del procesamiento analítico en línea (Online Analytical Processings, OLAP). Como depósito central de todos los datos empresariales relevantes, a los que suele accederse exclusivamente con permiso de lectura, el almacén de datos contribuye a la gestión del conocimiento interno del negocio. Como base sobre la cual trabajan los diversos métodos de minería de datos, el contenido de un DWH sostiene todas las reflexiones y tomas de decisiones en relación con la gestión del rendimiento y la planificación estratégica del negocio.

¿Cómo se estructura un data warehouse?

Al proceso de gestión y examen de un almacén de datos se le denomina data warehousing y este comprende las siguientes fases:

- Obtención e integración de los datos

- Conservación de los datos

- Evaluación y análisis de los datos

Estas tres fases se reflejan en una arquitectura ideal básica, un modelo de referencia de los sistemas de almacén de datos que, si bien puede constatar diferencias en función del producto y el fabricante, en principio se orienta por una estructura modular a tres niveles:

- Recolección

- Almacenamiento y conservación

- Entrega (para su consulta)

A estos tres niveles se añade un componente central de control, el gestor del almacén de datos (Data Warehouse Manager), que asigna a cada nivel funciones especiales de administración.

Los diversos componentes que integran un almacén de datos no tienen que proceder del mismo fabricante, sino que pueden tener origen en productos de software diferentes o en soluciones individuales.

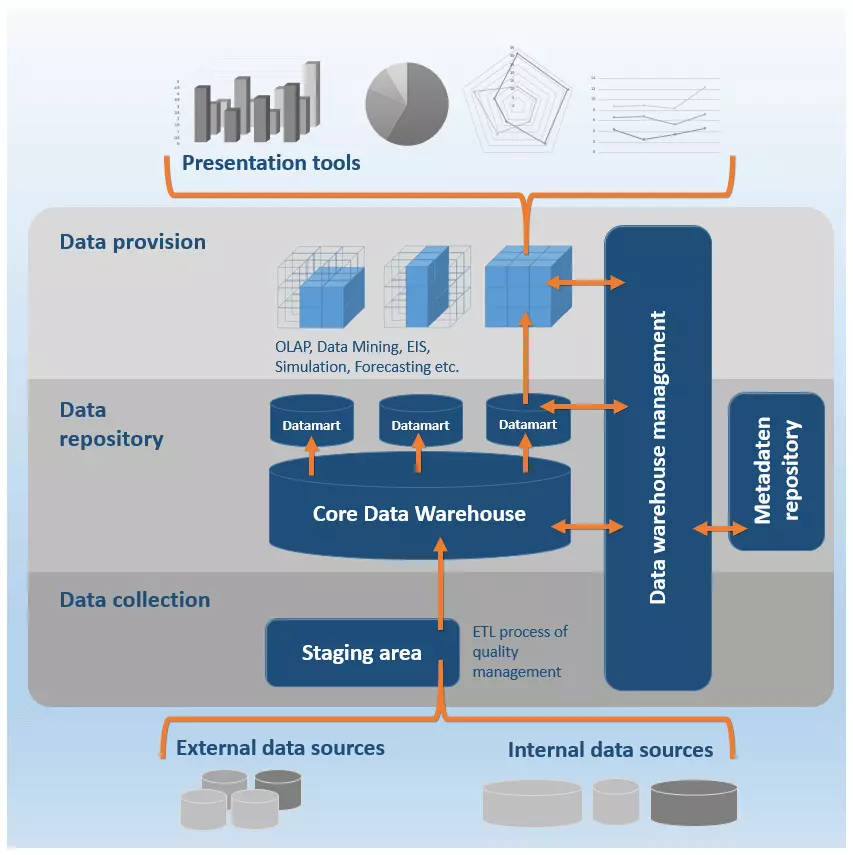

El siguiente gráfico ilustra esquemáticamente la arquitectura de referencia de un data warehouse:

Nivel de obtención de los datos

Antes de cargar los datos en el almacén, esta información, a menudo muy diversa, se ha de convertir a un formato homogéneo. Un almacén de datos se nutre tanto de fuentes internas de la empresa como de fuentes externas especialmente relevantes:

- Datos internos de sistemas de planificación de recursos de empresa (Enterprise Resource Planning, ERP), de sistemas gestión de las relaciones con los clientes (Customer Relationship Management, CRM), de bases de datos transaccionales, de gestores de contenido (CMS), de archivos (Excel, CSV, texto), de correos electrónicos, etc.

- Datos externos desde aplicaciones y sistemas de terceros, páginas web o Internet, redes sociales, servicios en la nube, etc.

Los sistemas que actúan en este nivel se comunican con los sistemas operacionales de una empresa por medio de interfaces que se utilizan en la primera fase del almacenamiento del data warehousing. Las funciones centrales de estos sistemas son la recolección y la integración de los datos.

Los datos se obtienen utilizando los siguientes métodos de extracción:

- Trigger (disparador): si los sistemas operacionales de una empresa soportan disparadores de bases de datos, estos se pueden utilizar para automatizar la extracción de datos. Los disparadores permiten definir operaciones que se ejecutan tan pronto de producen determinados eventos, que suelen consistir en cambios en la base de datos del sistema de origen. Esto conduce a la extracción de los datos modificados hacia el almacén de datos.

- Archivos de protocolo: si un sistema operacional no soporta la tecnología de disparadores, el nivel de recolección de datos puede contener programas capaces de examinar los archivos de protocolo o logs del sistema de origen y extraer las operaciones que han registrado.

- Programas de monitorización: si no se cuenta con disparador ni con archivos de protocolo, suelen utilizarse programas de supervisión que extraen los cambios en los datos de un sistema operacional a partir de algoritmos que generan snapshots de los datos periódicamente y los comparan con los anteriores.

Cuando, al no ser posible acceder a las bases de datos, los sistemas no soportan ninguno de estos tres métodos, han de ser ellos mismos los que protocolicen los posibles cambios y envíen cualquier modificación relevante al data warehouse.

En cuanto a la integración de los datos, la mayor parte de almacenes de datos contienen funciones de procesamiento analítico en línea (OLAP) que permiten trasladar los datos a estructuras multidimensionales. El denominado Online Analytical Processing es un método analítico basado en el proceso ETL con el que se comprimen los datos de gestión relevantes para la empresa:

- E = Extraction (extracción): en la fase de extracción de los datos se selecciona la información relevante desde diferentes fuentes siguiendo una estrategia de push o de pull. Si los datos se extraen por la estrategia de push, las fuentes de datos son impelidas a generar extractos regularmente y enviarlos al almacén de datos. Si se extraen por la estrategia de pull, es el almacén de datos el que impulsa la extracción.

- T = Transformation (transformación): en esta fase los datos que se han extraído se depuran y se traducen al formato de la base de datos donde se deben guardar.

- L= Loading (carga): en esta fase se guardan los datos ya transformados en su base de datos correspondiente en el almacén de datos.

Este primer nivel de recolección puede contener una denominada staging area, un área temporal en la cual los datos que se van a cargar se someten a una preparación previa, lo que puede resultar necesario en el caso de procesos ETL muy complejos.

Al proceder de fuentes diferentes, la integración de estos datos en el almacén recurre a diversas herramientas de transformación y limpieza que pueden clasificarse según estas tres categorías.

- Herramientas de migración de datos: estos programas permiten definir reglas simples de transformación que conviertan los datos de salida heterogéneos en un formato de destino uniforme.

- Herramientas de limpieza: en este caso, estos programas se apoyan en la llamada lógica difusa (fuzzy logic) y en las redes neuronales para mejorar la calidad de los datos en tanto que corrige errores, datos incompletos y repeticiones. Para llevar a cabo esta depuración de registros, utiliza reglas predefinidas, algoritmos o tablas de consulta (lookup tables). Esta operación también suele denominarse gestión de la calidad (quality management).

- Herramientas de auditoría de datos: estos programas se utilizan para encontrar reglas y relaciones entre los datos, así como también para identificar aquellos que contravienen las reglas definidas y son previsiblemente erróneos.

Tras la integración, los datos extraídos entran en la base de datos central (Core Data Warehouse) mediante programas que:

- Prueban las condiciones de integridad

- Clasifican los datos

- Calculan las agregaciones

- Calculan las estructuras de acceso

- Fragmentan los datos para que el acceso sea más eficiente

Nivel de conservación de los datos

Este nivel constituye el núcleo del almacén de datos y comprende el denominado Core Data Warehouse o almacén maestro. Los datos extraídos en la fase anterior se guardan en él en la forma de matrices multidimensionales (esquemas de bola de nieve y de estrella) y se mantienen aquí con vistas a ser archivados a largo plazo para análisis futuros. Dado que estos análisis rara vez tienen como objeto el contenido completo del almacén de datos, para garantizar un examen eficiente suele ser habitual crear los denominados data marts (mercados de datos), basados en subconjuntos o extractos de la información total contenida en el almacén central.

Un data mart es una copia de un subconjunto de datos generalmente realizada como copia temporal no persistente. En ocasiones también se utilizan los llamados data marts independientes, que guardan un subconjunto de datos separado de forma perdurable.

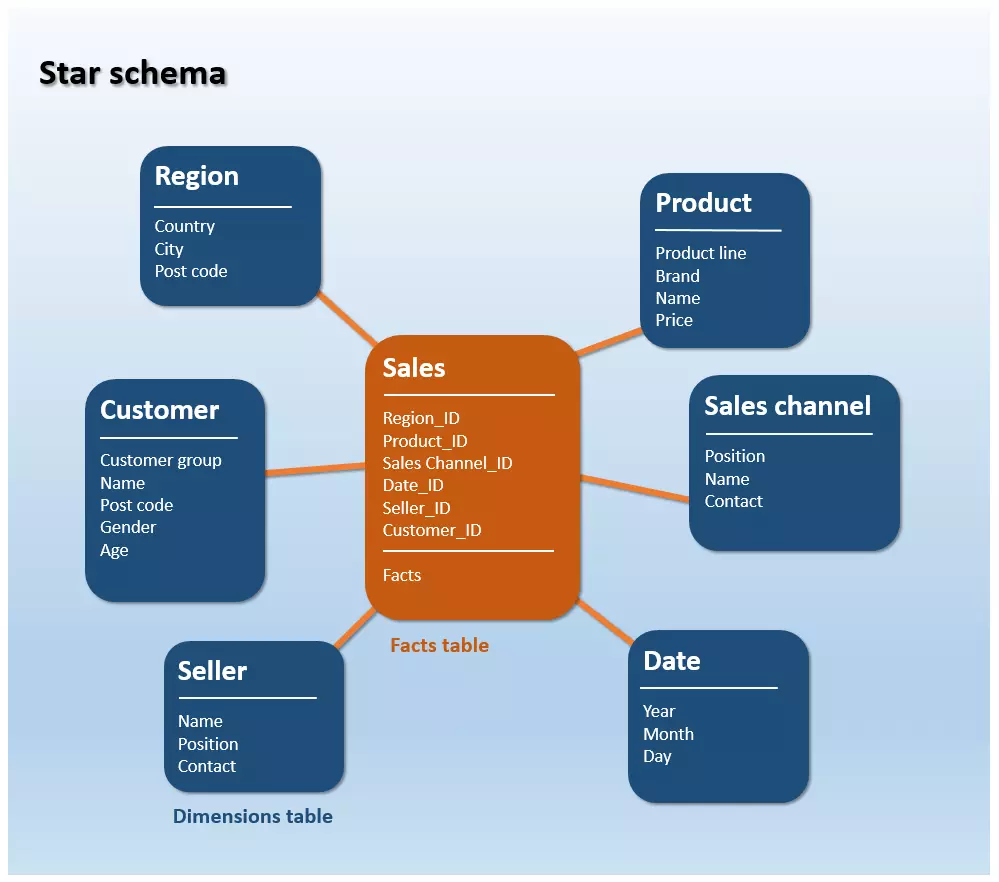

Un esquema en estrella es un tipo de diagrama entidad-relación (Entity Relationship Diagram, ERD), es decir, una representación gráfica de la estructura tabular de una base de datos que ilustra tanto las diferentes entidades como las relaciones entre ellas. Así, un esquema en estrella sirve para visualizar estructuras de datos multidimensionales.

Los esquemas en estrella están compuestos por una tabla de hechos y varias tablas de dimensiones alrededor de ella, adquiriendo la característica forma de estrella que da nombre al esquema:

- La tabla de hechos contiene los índices y las métricas sobre los eventos de una empresa que se deben registrar de forma continua (el volumen de ventas, por ejemplo).

- Las tablas de dimensiones contienen atributos que describen los datos de la tabla de hechos. Se trata así de un conjunto de datos de referencia para los eventos registrados en la tabla de hechos.

En este tipo de esquema, la tabla de hechos está conectada por relaciones de clave externa con todas sus tablas de dimensiones, pero no estas entre sí. La siguiente imagen muestra una representación simplificada de esta estructura de datos:

En este esquema en estrella a modo de ejemplo puede verse la relación entre el hecho «Ventas» (Sales) y un determinado «Canal de ventas» (Sales channel), «Producto» (Product), «Vendedor» (Seller), una «Región» (Region) o un «Periodo de tiempo» (Date). Una posible consulta que abarque tres dimensiones podría ser: ¿cuánto beneficio se obtuvo en 2016 con el producto «mesas» en el canal de venta online?

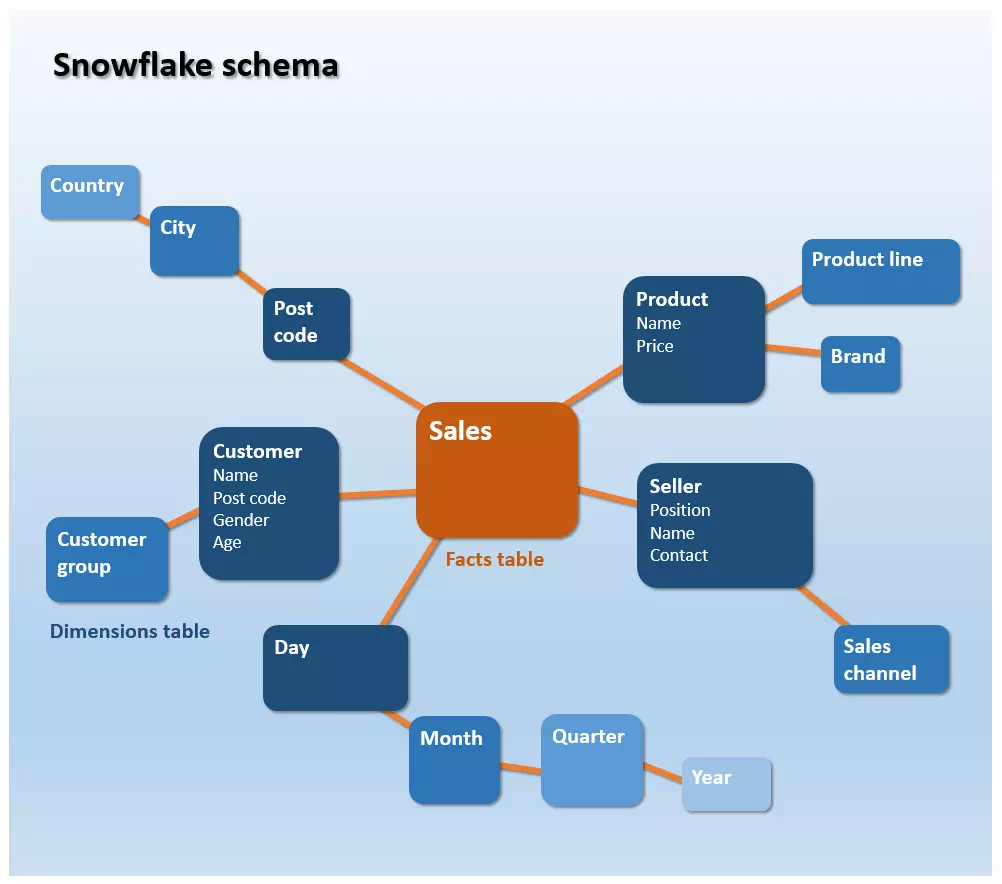

Una evolución del esquema de estrella es el esquema en copo de nieve (snowflake schema). Mientras que las tablas de dimensiones de un esquema en estrella no están normalizadas, la información referencial en un esquema de copo de nieve se almacena según la tercera norma formal (3NF): los datos se clasifican y ordenan jerárquicamente y la información redundante se guarda en tablas separadas. Es así como se crean las estrellas ramificadas que recuerdan a la estructura interna de los copos de nieve.

Frente a las estructuras en estrella, los sistemas en forma de copo de nieve se caracterizan por una menor utilización de memoria, que resulta del almacenamiento normalizado de los datos. Se entiende como normalización de bases de datos el desplazamiento de columnas a tablas nuevas con el fin de evitar registros duplicados. Al reducirse la redundancia, también disminuye la necesidad de mantenimiento de los datos: el objetivo es que la información figure una sola vez y solo haya que modificarse en un solo lugar si es necesario hacerlo. Sin embargo, cuando los datos se depositan en tablas normalizadas se crean necesariamente estructuras muy complejas que ralentizan el procesamiento de las consultas. Para acceder a los datos de un esquema en copo de nieve, los analistas deben primero conectar las tablas de dimensiones en varias capas mediante joins.

un join es una operación con la cual se pueden agrupar bases de datos conectadas con una clave externa bajo unas condiciones determinadas.

En la práctica, la estructura de un almacén de datos suele basarse en el esquema en copo de nieve, mientras que los mercados de datos se implementan siguiendo el esquema en estrella.

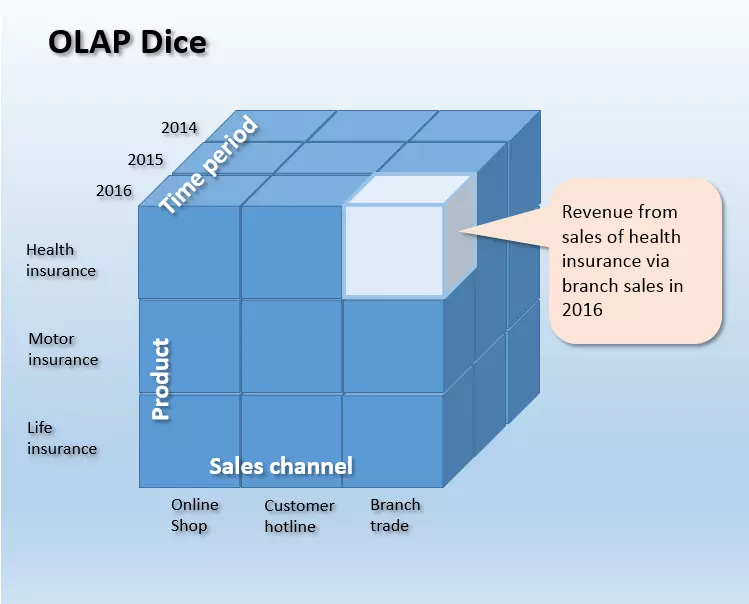

Con frecuencia se hace referencia a estos esquemas como tablas de dimensiones porque se pueden representar como una dimensión del cubo OLAP multidimensional. Esto permite a los científicos de datos establecer relaciones entre los hechos almacenados en el almacén y todo tipo de información de referencia que permite analizar indicadores operativos del negocio (como, por ejemplo, el volumen de ventas) de forma multidimensional a partir de diferentes aspectos y examinarlos en diversos niveles de detalle.

La siguiente figura muestra esquemáticamente un cubo OLAP, cuyos lados comprenden las dimensiones “Gama de productos”, “Canal de distribución” y “Periodo” y cuya longitud, a su vez, se ve determinada por el número de celdas. Cada celda del cubo contiene una sola cifra, por ejemplo, como en la imagen, el volumen de ventas para el producto “Seguro de vida” a través del canal de venta “Sucursal de venta” en el año “2016” (destacado en azul claro en la imagen):

Este procedimiento no está limitado a las tres dimensiones, pues un cubo de datos es multidimensional y puede comprender tantas dimensiones como sean necesarias.

en función de la tecnología que fundamenta el DWH maestro se puede diferenciar entre diversos métodos de OLAP. Si un cubo de datos toma sus datos de una base de datos relacional se habla de un ROLAP u OLAP relacional, mientras que los cubos basados en bases de datos multidimensionales se llaman MOLAP (OLAP multidimensional).

Nivel de entrega de los datos

Este nivel funciona como interfaz para las aplicaciones finales y las herramientas de presentación, que facilitan métodos de análisis y evaluación de datos que permiten extraer la información de los almacenes de datos y prepararlos de distintas formas para el usuario final. Entre estas se incluyen herramientas de elaboración de informes y de consultas, de colaboración, de minería de datos, de OLAP, sistemas de información ejecutiva (EIS) y herramientas de proyección y simulación.

Herramientas de consulta e informes

Este tipo de programas ponen a disposición del usuario diferentes funciones para elaborar informes estándar (predefined reportings) de forma automatizada cada cierto tiempo o bajo petición. Los programas de consulta simplifican la realización de consultas al almacén de datos predefiniéndolas.

Herramientas de colaboración

Los programas de colaboración apoyan la comunicación y el trabajo conjunto de los usuarios en el análisis de los datos. La gama de funciones de estas herramientas comprende, por ejemplo, el almacenamiento de comentarios y el intercambio de resultados de análisis.

Herramientas de minería de datos

Bajo el título de data mining o minería de datos se engloban todos aquellos métodos de análisis no direccionales, en parte automatizados, que tienen como objetivo encontrar patrones, tendencias y relaciones relevantes en la información. Los programas de minería de datos se apoyan en métodos estadísticos y matemáticos, así como en tecnologías de inteligencia artificial (KI) y de aprendizaje automático. El volumen de los datos que las empresas generan, procesan y agrupan en almacenes de datos para analizarlos crece de forma exponencial y cada dos años se duplica el volumen medio de datos en todo el mundo. En este contexto, los métodos de minería de datos aplicados al data warehousing no hacen más que ganar en relevancia.

Herramientas de Online Analytical Processing (OLAP)

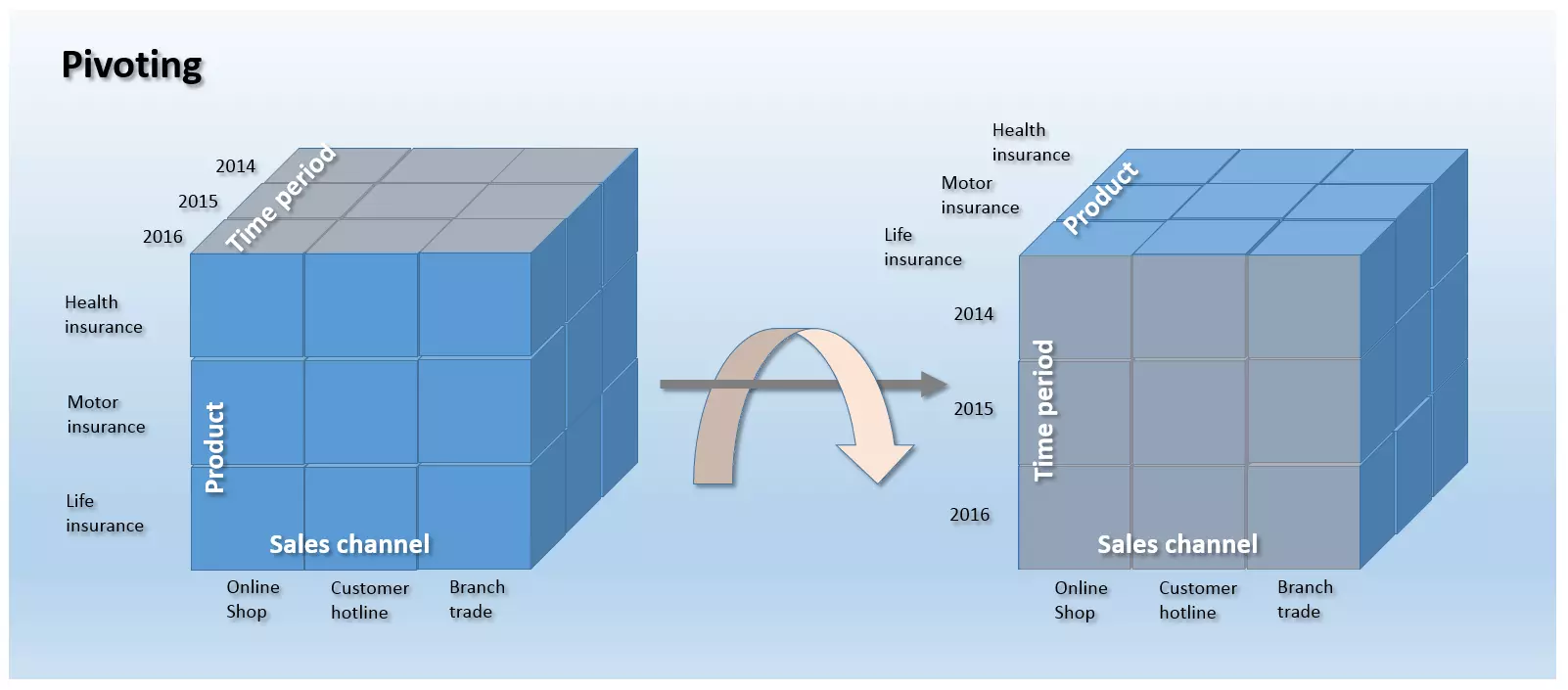

Entre las herramientas disponibles de análisis y evaluación en almacenes de datos se han consolidado las aplicaciones de OLAP como interfaz estándar de usuario. Las herramientas que se utilizan en el marco del procesamiento analítico en línea presentan funciones con las cuales los usuarios pueden formular consultas específicas (ad hoc) al almacén de datos que permiten explorar el contenido multidimensional del mismo. Su representación por el método OLAP permite modelar los datos depurados en relación con tantas dimensiones predefinidas como sean necesarias. En este proceso, los analistas pueden recurrir a diversas operaciones con las cuales se puede editar un cubo OLAP:

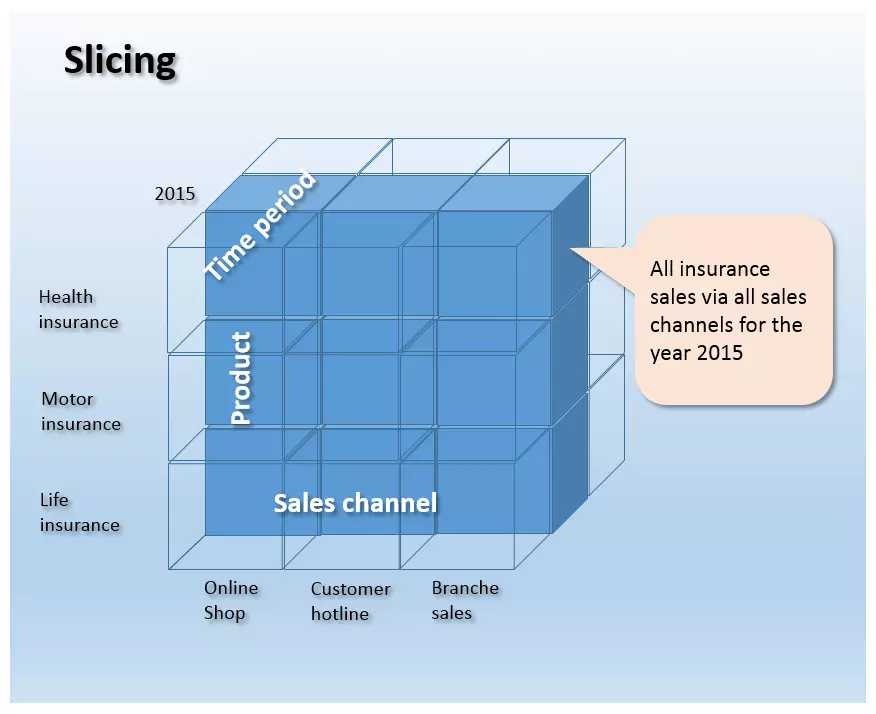

- Slicing: se conoce como slicing el procedimiento por el cual se delimita una dimensión del cubo OLAP por una porción cuantitativa, prácticamente como si se cortara un “trozo” de datos y se estudiara por separado.

En esta imagen se ha aislado la porción “2015” de la dimensión “Periodo”, de modo que muestra todas las ventas que se han generado en 2015 en todos los canales.

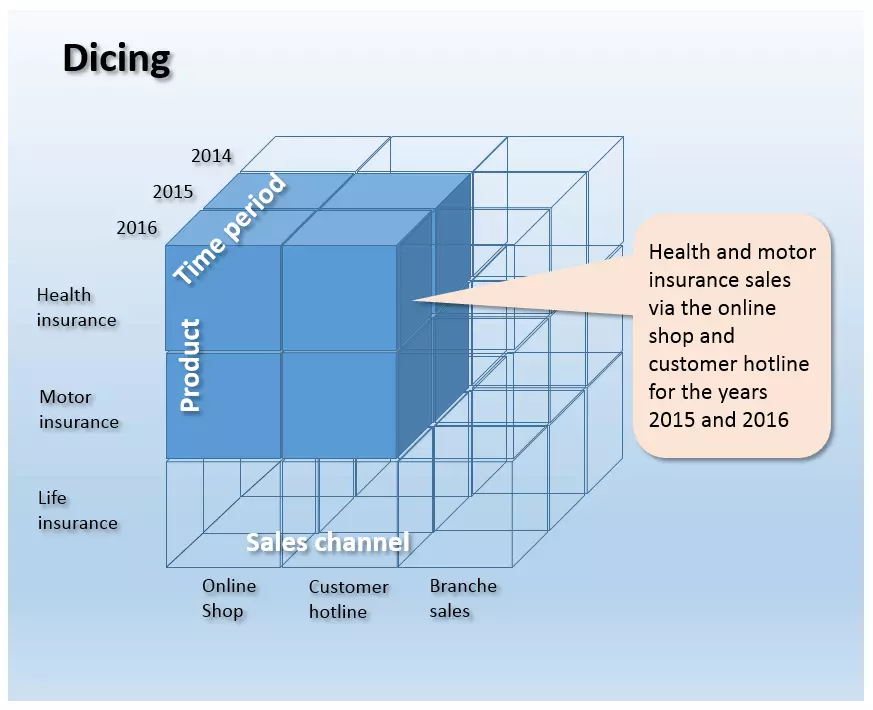

Dicing: cuando se interviene en un cubo OLAP con varias operaciones de slicing simultáneas en varias dimensiones se habla de dicing, porque se crea un cubo nuevo más reducido que contiene una porción del cubo global.

La siguiente imagen muestra una operación de dicing en la cual el cubo tridimensional se reduce en tres dimensiones a una porción de información:

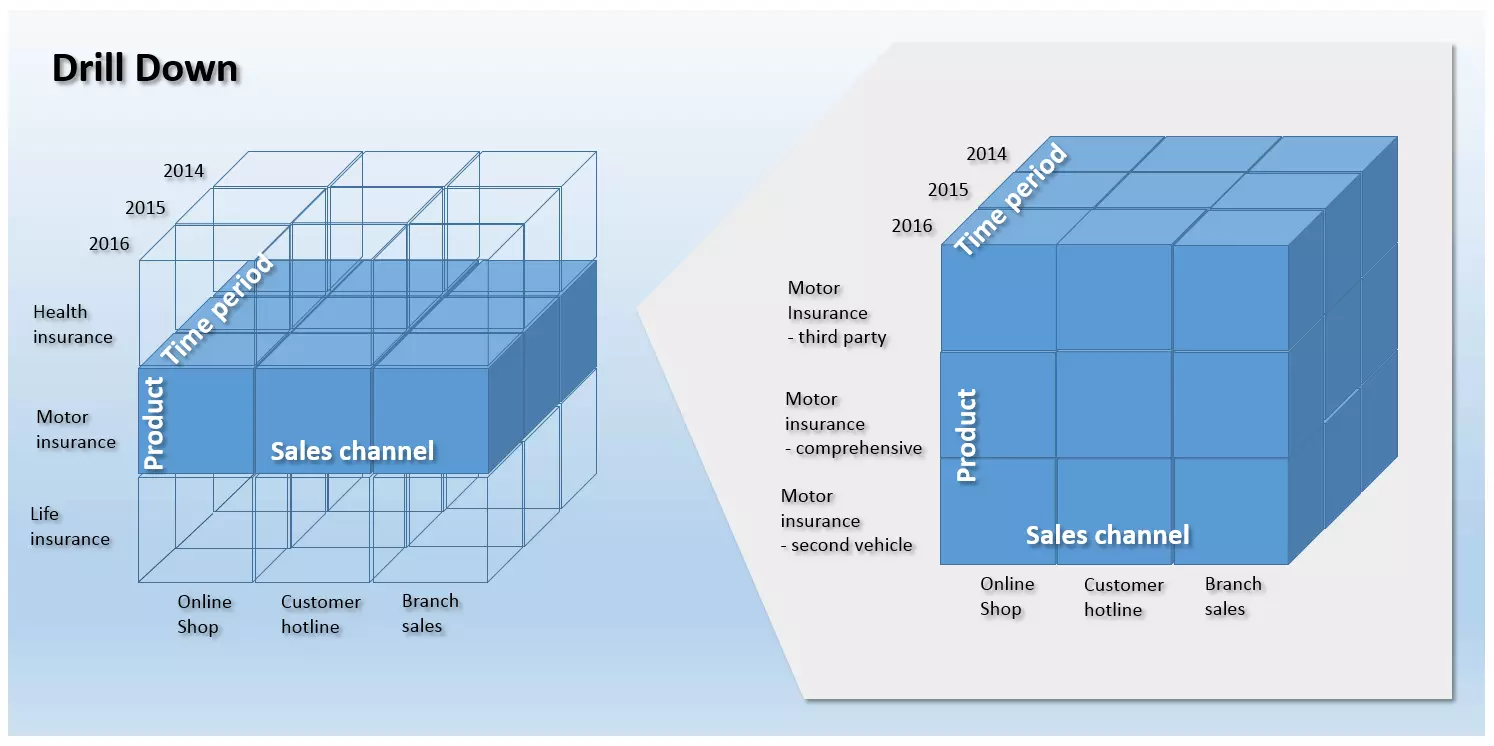

Drill down/Roll up: cuando las variables de un objeto se deben desglosar a valores aún más detallados se utiliza la operación drill down, que permite a los analistas ampliar una sección del cubo OLAP para aumentar su grado de detalle. La operación inversa se denomina roll up y en ella se compacta la información a niveles más altos de la jerarquía. Ambos se utilizan en la navegación en estructuras jerárquicas multidimensionales.

La siguiente imagen muestra un drill down del objeto “Ventas” en la dimensión “Productos”. Al ampliar el detalle, las cifras de ventas pueden interpretarse en relación con cada producto en particular.

- Drill out/Split: esta operación permite a los analistas añadir más dimensiones a un cubo OLAP resultando así datos más exhaustivos pero, a diferencia de una operación drill down, el grado de detalle no depende de la granularidad o especificidad, sino de un aumento de la información, resultado de las nuevas dimensiones añadidas.

- Drill in/Merge: la operación contraria al drill out consiste en reducir el grado de detalle del cubo de OLAP eliminando dimensiones. Al contrario que el roll up, en esta operación la pérdida de información no resulta de un cambio del nivel de observación, sino de la pérdida de información dimensional. La granularidad no cambia.

- Drill across: mientras que las operaciones precedentes siempre se refieren a un único cubo de OLAP, este método se aplica en varios cubos condicionados para permitir análisis globales. En este proceso se analizan varias tablas de datos con al menos una dimensión en común en el mismo nivel jerárquico y con la misma granularidad, es decir, preservando el nivel de observación.

- Drill through: en este caso el analista selecciona una única celda del cubo de datos y la observa en su mayor grado de detalle, pero, a diferencia del drill down, el drill through recurre a los datos originales de la celda seleccionada. De este modo, el resultado de esta operación deriva de las celdas de la tabla que han servido para calcular la celda seleccionada del cubo.

Sistemas de información ejecutiva (EIS)

Cercanas al OLAP, las herramientas de EIS ponen a disposición de los usuarios distintas opciones a la hora de formular consultas específicas y modelar los datos. Hoy, no obstante, para diferenciarlo de OLAP, el nombre de Executive Information Systems se utiliza sobre todo en relación con sistemas de aplicaciones que facilitan informes predefinidos para ciertos sectores operativos como la venta, el marketing o la planificación financiera.

Herramientas de previsión y simulación

Las forecasting and simulation tools permiten a los usuarios extrapolar al futuro los indicadores guardados en el DWH para poder elaborar modelos de predicción.

Gestión de almacenes de datos

En todos los niveles de un data warehouse se encuentran contenidas diversas herramientas que suelen incluirse en el ámbito de la gestión de almacenes y cuya misión consiste en crear, mantener y operar todas las funciones administrativas necesarias en un almacén de datos. Tareas centrales de este gestor de DWH son la planificación (scheduling) de los procesos y la gestión de los metadatos, de la seguridad y del sistema.

- Scheduling: la planificación engloba el control de los procesos en el almacén de datos. Las funciones de administración en esta sección se pueden organizar en la siguientes categorías en relación con los tres niveles de la arquitectura del almacén:

- Registro e integración de los datos: en el nivel de recogida de datos, el gestor es responsable del diseño y del ajuste de los procesos ETL, así como de supervisar las actualizaciones y la gestión de la calidad.

- Mantenimiento de los datos: en el nivel de mantenimiento de datos, el DWH manager supervisa la carga de la memoria, construye tablas de agregación y ejecuta operaciones de archivado y de copia de seguridad.

- Entrega de los datos: las funciones de administración en este nivel incluyen la gestión de los usuarios y la supervisión de la duración de ejecución de las consultas.

- Gestión de los metadatos: el repositorio de metadatos es un componente central de todo almacén de datos porque contiene toda la información necesaria para su construcción y funcionamiento, así como todo tipo de información sobre el volumen de datos que guarda. Estos metadatos abarcan, por ejemplo, la definición del esquema de base de datos que fundamenta el DWH, los datos sobre las estructuras de memoria, sobre las rutas de acceso y tamaños de los archivos, metadatos que describen las fuentes de los datos, así como el día y la hora en que tienen lugar las actualizaciones, las reglas de depuración y de transformación de los datos, índices y tablas de partición. El gestor también se ocupa del intercambio de metadatos entre cada uno de los componentes del almacén y facilita una base de metadatos homogénea.

- Gestión de la seguridad: aquí tienen lugar diversos servicios incluidos en la autenticación de usuarios, de autorización y de cifrado.

- Gestión del sistema: aquí el gestor del DWH facilita diferentes funciones de administración para el funcionamiento del almacén de datos propiamente dicho, entre ellas el monitoring (rendimiento, carga, etc.), el archivado de los datos o la copia de los datos.

Almacenamiento y protección datos en los data warehouses

La agregación a gran escala de datos operativos, de negocio y de los clientes en un almacén de datos, así como su análisis con ayuda de métodos de data mining o de operaciones de OLAP, ofrece a las empresas una gran oportunidad a la hora de optimizar los procesos de negocio de forma sostenible. Junto a sus ventajas para la toma de decisiones, los abanderados de la protección de datos, sin embargo, también ponen de relieve los riesgos que este tipo de análisis de big data traen consigo, en particular para el derecho fundamental al control de la propia información y la protección de la esfera privada. Según los críticos, los análisis que permiten la creación de perfiles personales y la predicción automatizada de formas de comportamiento y de actuación son los más peliagudos. En el centro del debate se sitúa el potencial de manipulación de los datos que se obtienen de estos análisis. Si bien la legislación española no hace referencia a los almacenes de datos como tales, sí establece las responsabilidades de los denominados «responsables de los ficheros y de su tratamiento», denominación que incluye a personas físicas o jurídicas, es decir, a empresas públicas o privadas con un archivo de datos personales a su cargo, como un almacén de datos. La Ley Orgánica 15/1999, de 13 de diciembre, de Protección de Datos de Carácter Personal, conocida como LOPD, define estas responsabilidades como obligaciones: 1. Inscripción del fichero: el responsable de los ficheros ha de notificarlos ante el Registro General de Protección de Datos para proceder a su inscripción. No solicitarla constituye una infracción leve según recoge la ley.

2. Calidad de los datos: la empresa o el responsable del fichero ha de garantizar que los datos que ha recogido son adecuados y veraces, se han recabado legítimamente y son utilizados exclusivamente para el fin para el que se obtuvieron. Este es un derecho fundamental recogido por el Tribunal Constitucional Europeo en la sentencia 292/2000 como derecho de autodeterminación informativa o de libre disponibilidad de los datos de carácter personal. Entre los principios asociados a la calidad de los datos, la LOPD y la RLOPD recogen que los datos son de calidad cuando son pertinentes y adecuados a la finalidad, se cancelan cuando ya no son necesarios para la finalidad con la que fueron recabados o no se recogen por medios ilícitos, desleales o fraudulentos (infracción grave recogida en el artículo 44.4.a).

3. Deber de guardar secreto (art. 10): la empresa ha de garantizar que se cumplen los deberes de secreto y seguridad (salvaguardarlos del acceso no autorizado de terceros). El artículo 9 impone a los responsables de ficheros adoptar las medidas necesarias para garantizar la seguridad técnica del archivo. Para facilitar a las empresas el cumplimiento de la LOPD, la Agencia Estatal por la protección de los datos ha elaborado esta guía de seguridad.

4. Deber de información (art. 5): antes de recabar los datos de ha de informar al interesado al respecto y obtener su debido consentimiento.

5. Atención de los derechos de los ciudadanos: se ha de garantizar que el ciudadano pueda ejercer su derecho de oposición, acceso, rectificación y cancelación; que las empresas con las que se colabora también cumplan con lo establecido en la LOPD, y cumplir con la legislación sectorial correspondiente. Según el artículo 44.3.e) de la LOPD "El impedimento o la obstaculización del ejercicio de los derechos de acceso, rectificación, cancelación y oposición" constituye una falta grave. Sin delimitar explícitamente el caso de los almacenes de datos y de los procedimientos de análisis de big data, de la LOPD se extrae lo establecido por la AEPD en materia de almacenamiento de datos de cualquier forma que permita su tratamiento y su análisis, también en DWH. No cumplir con lo establecido puede desembocar en una infracción de mayor o menor gravedad, como la que ha recaído recientemente sobre Facebook por parte de la AEPD a raíz de una investigación a cargo de un Grupo de Contacto compuesto por las Autoridades de Protección de Datos de Bélgica, España, Francia, Hamburgo (Alemania) y Países Bajos.

Software para data warehouses

El archivado en almacenes de datos ya no es un lujo exclusivo de las grandes corporaciones, pues las pequeñas y medianas empresas empiezan a descubrir el potencial derivado de la optimización de los procesos mediante el análisis de grandes volúmenes de datos. Al lado de suites profesionales de Business Intelligence y soluciones completas de DWH han ido surgiendo en los últimos años productos más asequibles con los que iniciarse, servicios en la nube más flexibles y aplicaciones de código abierto más ajustadas a las necesidades de la pyme.

Programas de data warehousing de pago

El software comercial de BI con cierto renombre suele distinguirse por una elevada fiabilidad, una gama de funciones acorde con los Service Level Agreements (SLA) y una atención al cliente de gran calidad, pero también por el coste de su adquisición o de su utilización como servicio en la nube.

La siguiente lista enumera los productos de pago disponibles en la actualidad de fabricantes de primera línea en orden alfabético:

| Proveedores de software propietario | Productos de data warehousing |

|---|---|

| Amazon Web Services | Amazon Redshift |

| Cloudera | Cloudera Enterprise |

| Hewlett Packard Enterprise | HP Vertica |

| HP ArcSight Data-Platform | |

| HP Haven OnDemand | |

| HP IDOL | |

| HP Key View | |

| IBM | IBM Netezza |

| IBM PureData System | |

| IBM InfoSphere DataStage | |

| Microsoft | SQL Server |

| Microsoft Analytics Platform System | |

| Azure HDInsight for Hadoop | |

| Oracle | Oracle Business Intelligence |

| Oracle Database | |

| Oracle Exadata Database Machine | |

| Oracle NoSQL Database | |

| Oracle TimesTen In-Memory Database | |

| Oracle Big Data Appliance | |

| Pivotal Software | Pivotal Greenplum |

| Pivotal Big Data Suite | |

| Pivotal HDB (powered by Apache HAWQ) | |

| Pivotal HDP (OEM Hortonsworks Data Platform) | |

| SAP | SAP NetWeaver Business Intelligence |

| SAP IQ | |

| SAP HANA Enterprise Cloud | |

| SAS | SAS Data Management |

| SAS Access Interface to Hadoop | |

| SAS Federation Server | |

| SAS Data Loader for Hadoop | |

| SAS Event Stream Processing | |

| Snowflake Computing | Snowflake |

| Teradata | Teradata Active Enterprise Data Warehouse |

| Teradata Data Warehouse Appliance | |

| Teradata Appliance for Hadoop | |

| Teradata Integrated Big Data Platform | |

| Teradata Aster Big Analytics Appliance |

Soluciones open source de data warehousing

Además de las soluciones propietarias de alto nivel, el mercado del software de inteligencia de negocio también ofrece soluciones de código abierto que facilitan funciones de data warehousing de forma gratuita. La siguiente comparativa se basa en información del Ministerio Alemán de Economía y Energía y muestra los programas más utilizados así como sus ámbitos de aplicación:

| Software BI | Extrae datos puros | Transforma datos puros | Carga datos transformados | OLAP | Data Mining | Panel de control | Informes |

|---|---|---|---|---|---|---|---|

| Pentaho DI | - | - | - | - | |||

| Talend OS | - | - | - | - | |||

| Jasper ETL | - | - | - | - | |||

| Pentaho Mondrian | - | - | - | - | |||

| Jedox | - | - | - | ||||

| BIRT | - | - | - | - | |||

| SQL Power Wabit | - | - | - | ||||

| KNIME | - | ||||||

| RapidMiner | |||||||

| Weka | - | - | |||||

| JasperSoft | |||||||

| Pentaho | |||||||

| SpagoBI |

En función de sus ámbitos de aplicación, estos programas de la lista pueden ser clasificados como software de ETL, de OLAP, de data mining o de elaboración de informes. También se encuentran soluciones integradas de BI que cubren todos los aspectos de aplicación.

Software de ETL

Para la recogida e integración de los datos en los procesos de ETL, los programas Pentaho DI, Talend OS y Jasper ETL son los más adecuados.

- Pentaho DI: conocida también como Kettle, la herramienta de ETL Pentaho Data Integration (DI) forma parte de la suite Pentaho BI, aunque también se puede utilizar en estructuras de data warehousing como aplicación independiente. Esta herramienta de recogida e integración dispone de una interfaz gráfica que también permite gestionar procesos de ETL a usuarios sin conocimientos en programación. Para ello Pentaho DI facilita una amplia paleta de módulos con los cuales se pueden definir los pasos que componen un proceso de ETL. La herramienta soporta todos los sistemas de base de datos habituales y puede extraer datos de archivos planos como CSV, Excel o de texto. Asimismo también facilita interfaces a suites de BI propietarias de SAS o SAP así como a software de análisis como Google Analytics.

- Talend OS: la herramienta de Talend es comparable a Pentaho DI porque también permite al usuario definir los procesos de recogida y de integración de datos mediante módulos parametrizados (los llamados Jobs). Talend Open Studio ofrece interfaces a todas las fuentes de datos más habituales y a diversas funciones de transformación de datos. Un editor de mapas permite a los usuarios pasar datos heterogéneos sin tratar a una estructura predefinida. Como Pentaho DI, Talend OS también dispone de una interfaz gráfica amable con los menos experimentados en programación.

- Jasper ETL: Jasper ETL es el resultado de una cooperación entre las compañías de software Jaspersoft y Talend y se basa en lo esencial en Talend OS, la herramienta de integración que domina el mercado open source. Vale la pena decantarse por él especialmente si se utilizan otros productos de BI de Jaspersoft en la estructura del almacén de datos.

Aplicaciones de OLAP

Entre las herramientas de OLAP encontramos las consolidadas Pentaho Mondrian y Jedox.

- Pentaho Mondrian: Mondrian es un servidor OLAP basado en Java. Originariamente desarrollado como proyecto open source autónomo, desde 2006 forma parte de la suite Pentaho BI aun estando disponible como aplicación independiente e incluida en las soluciones BI de otros fabricantes como Jaspersoft. De esta manera los usuarios obtienen beneficio de una unión de recursos de código abierto que facilita proyectos comunes como Workbench o la interfaz OLAP4J. El proyecto Mondrian persigue un principio relacional (ROLAP) fundamentándose en una base de datos relacional, cuyas tablas se organizan en esquemas de estrella o de copo de nieve. El acceso a ella se realiza en la forma de consulta multidimensional (MDX), por XML for Analysis (XMLA) o con la interfaz de Java OLAP4J. El esquema de Mondrian Workbench proporciona la interfaz gráfica al programa. Los esquemas de Mondrian se pueden desarrollar y probar en el escritorio sin dificultad.

- Jedox: el desarrollador de software Jedox ofrece con su suite homónima una solución completa para aplicaciones de BI y de gestión del rendimiento. El componente central del programa es un servidor OLAP In Memory de gran potencia que puede integrarse en otros entornos de software mediante interfaces para Java, PHP, C/C++ o .NET. Jedox resulta especialmente atractiva para los usuarios del sector de las pymes especialmente por el Excel Add In con el cual también se puede controlar el servidor OLAP desde la conocida hoja de cálculo de Microsoft. El uso de las aplicaciones ofimáticas está muy extendido en empresas pequeñas y medianas y a menudo representan la base del registro de los datos. Al integrar Excel en el programa se reduce considerablemente la necesidad de formar a los nuevos empleados en su uso.

Data mining

También en el campo de la minería de datos los usuarios cuentan con las correspondientes herramientas libres con licencia open source. De entre todas, recomendamos KNIME, RapidMiner y Weka.

- KNIME: KNIME (Konstanz Information Miner) es una herramienta de minería de datos desarrollada en la Universidad de Constanza, Alemania, que ofrece, siguiendo un concepto de fraccionamiento de datos (data pipelining) modular y procedimientos de análisis propios, posibilidades de integración de diversos algoritmos de minería de datos y de aprendizaje automático. En la interfaz gráfica se define cada uno de los pasos que integran la preparación de los datos (ETL), la modelización, el análisis y la visualización arrastrando los módulos y colocándolos en el apartado de trabajo que corresponda formando una hilera. La empresa madre KNIME.com AG sita en Suiza ofrece la descarga gratuita del software, además de apoyo técnico y servicio de asesoría en su central de Zúrich. Escrito en Java, KNIME se ofrece como plugin para la herramienta de programación Eclipse (IDE).

- RapidMiner: la plataforma de análisis RapidMiner de la compañía homónima propone un entorno integrado para aprendizaje automático, minería de datos, texto y web, análisis de sentimiento (minería de opinión) y de tiempo, así como modelos de predicción en un modelo open core. El programa soporta toda la escala del proceso de data mining, incluyendo la preparación de los datos, su visualización, su validación y su optimización. Aquellos usuarios para los cuales la versión gratuita, que solo incluye un procesador lógico y cuyo análisis solo abarca 10 mil registros como máximo, no es suficiente, pueden optar por una licencia Enterprise de pago. El programa está escrito en Java y ofrece una interfaz gráfica de usuario con la cual se puede diseñar y ejecutar el proceso de análisis usando el ratón.

- Weka: Weka, acrónimo de Waikato Environment for Knowledge Analysis, es un proyecto que nace en la Universidad de Waikato, en Nueva Zelanda. Esta herramienta de análisis ofrece a los usuarios diversos algoritmos de aprendizaje automático y, además de los métodos clásicos de data mining tales como la clasificación, la asociación y los análisis de regresión o de clústeres, Weka también contiene diversos componentes de tratamiento previo y de visualización de datos. El programa, escrito en Java, cuenta con una interfaz gráfica de usuario, pero también permite la interacción por medio de líneas de comandos. También facilita una interfaz de Java para integrar al programa en las soluciones propias de software.

Elaboración de informes

Instrumentos recomendables para elaborar informes son BIRT y SQL Power Wabit, herramientas que junto a los habituales informes mensuales, trimestrales o anuales, también contienen funciones ad hoc para tener acceso a datos relevantes en tiempo real.

- BIRT: BIRT (Business Intelligence and Reporting Tools) es un proyecto libre de la fundación Eclipse, que diseña funciones de BI Reporting para clientes enriquecidos (rich clients) y aplicaciones web. El software es adecuado especialmente para aplicaciones basadas en Java y cubre ampliamente la visualización de datos y la elaboración de informes. Los informes se diseñan en una interfaz gráfica de usuario basada en la herramienta de programación Eclipse y se guardan como archivos XML.

- SQL Power Wabit: esta herramienta de reporting permite elaborar informes basados en consultas clásicas a la base de datos y solo soporta cubos de OLAP si existe una descripción de la estructura de los datos. El programa soporta informes estándar, consultas ad hoc a la base de datos, páginas de resumen personalizadas y operaciones drill down en el contexto del Online Analytical Processing. Con funciones como el control por drag and drop, la actualización en vivo de los informes de resultados, una función de búsqueda global y un editor WYSIWYG para esbozar informes, SQL Power Wabit se ajusta también a los usuarios sin conocimientos de SQL. El editor permite crear exhaustivos informes con el ratón y personalizarlos ajustando la fuente, el color y la composición.

Soluciones integradas de Business Intelligence

Las opciones en cuanto a soluciones integradas de BI no se quedan en las suites de BI de los grandes fabricantes como SAP, Oracle, IBM, SAS, HP o Microsoft. El mercado del código abierto también ofrece proyectos de software que ponen a disposición de los usuarios soluciones de data warehousing en forma de compilaciones. De entre ellos destacan las suites Pentaho CE, Jaspersoft y SpagoBI.

- Pentaho Community Edition (CE): además de sus propios proyectos, la suite de Pentaho abarca una serie de otros proyectos open source que se integran paulatinamente en su portfolio de productos. Sus puntos fuertes radican en la integración de los datos y en la automatización de informes, siendo los programas:

- Pentaho Business Analytics Platform: aplicación web que permite a los usuarios depositar toda la información en un lugar central.

- Pentaho Data Integration: herramienta de ETL explicada con anterioridad.

- Pentaho Report Designer (PRD): se trata de una evolución de JFreeReport. La solución de reporting de código abierto soporta diversos formatos de salida, como PDF, Excel, HTML, Text, Rich Text File, XML y CSV.

- Pentaho Marketplace: el mercado permite al usuario ampliar la plataforma Pentaho con plugins.

- Pentaho Aggregation Designer (PAD): con PAC se crea y se optimiza el contenido de las bases de datos. El núcleo de la herramienta lo constituye el servidor OLAP Mondrian.

- Pentaho Schema Workbench (PSW): en este caso se trata de una interfaz gráfica de diseño para crear y probar esquemas para los cubos OLAP de Mondrian.

- Pentaho Metadata Editor (PME): PME se utiliza para describir de forma detallada las estructuras de datos subyacentes con ayuda de un archivo XML.

La edición Enterprise de Pentaho (EE) amplía la suite con una gama de funciones más extensa y soporte profesional a cambio de una suscripción.

- Jaspersoft: Jaspersoft también propone una solución integrada de BI conteniendo diferentes aplicaciones de data warehousing. La compilación abarca los siguientes programas:

- JasperReports Server: servidor de informes que facilita funciones OLAP en un servidor Mondrian adaptado.

- JasperReports Library: Jaspersoft facilita una biblioteca Java para poder crear informes.

- Jaspersoft Studio: este es el editor para crear los informes.

- Jaspersoft ETL: la herramienta de ETL basada en Talend OS se describió anteriormente.

- Mobile BI: aplicación nativa para terminales iPhone y Android para acceder a los informes y a los paneles de control desde el móvil.

Jaspersoft también cuenta con su versión comercial de pago con un abanico ampliado de funciones.

- SpagoBI: a diferencia de Pentaho y Jaspersoft, que comercializan sus productos con doble licencia, la iniciativa SpagoWorld ofrece su suite de BI exclusivamente como solución open source. Los usuarios profesionales pueden solicitar la configuración y el ajuste profesional del software como servicio de pago. La compilación incluye estos programas:

- SpagoBI Server: este servidor constituye el corazón de la suite abierta de BI y facilita diversas herramientas de análisis y funciones.

- SpagoBI Studio: se trata de un entorno integrado de desarrollo.

- SpagoBI Meta: entorno para la gestión de los metadatos.

- SpagoBI SDK: con este programa la suite de Spago dispone de una capa de integración que permite incorporar herramientas externas como Talend OS (ETL), Jedox o Mondrian (OLAP), Weka o R (data mining) o BIRT o JasperReports Library (informes).

Mantenimiento de los datos

En el terreno de la conservación de los datos los usuarios también pueden recurrir a una serie de alternativas de código abierto a sistemas de gestión propietarios como Microsoft SQL Server, IBM DB2 o a soluciones de Oracle y Teradata. Como almacén central de datos podemos contar con las bases de datos relacionales MySQL y MariaDB o el sistema de gestión relacional de objetos PostgreSQL. Pivotal ofrece a este último con licencia abierta y como evolución optimizada especial para arquitecturas de almacén de datos con el nombre de Greenplum Database.

El data warehousing llega a la pyme

El mercado de la Business Intelligence y los sistemas de data warehousing también ofrece, junto a soluciones de alto nivel, una amplia paleta de proyectos open source que contribuyen a reducir el obstáculo financiero que la entrada en el mundo del big data supone para la pequeña y la mediana empresa.

A la hora de implementar soluciones de BI, se recomienda a estas empresas centrarse primero en la elaboración de informes. Ya con algunas tareas sencillas es posible para las empresas obtener los primeros beneficios de la reunión de todos los datos en un solo lugar. Si durante el examen se ponen de relieve huecos en la información almacenada, en un siguiente paso se podría reorganizar la recogida de datos con ayuda de las herramientas de ETL u OLAP que se han presentado aquí. La incorporación de una arquitectura de DWH en la infraestructura informática de la empresa concluye con las herramientas de minería de datos, las cuales pueden detectar tendencias y relaciones nuevas mediante análisis continuos (análisis de carritos de la compra) de forma que pueden entregar información muy relevante para la toma de decisiones estratégicas.

Las pymes que tengan la intención de utilizar un almacén de datos no pueden perder de vista las implicaciones en cuanto a la protección y la seguridad de los datos de la estrategia de BI.